- Хранение данных. Или что такое NAS, SAN и прочие умные сокращения простыми словами

- Зачем это все?

- Хранение данных

- Unified storage

- Гиперконвергентные системы

- Облака и эфемерные хранилища

- Заключение

- Обработка и хранение данных: от древности до ЦОДов

- До изобретения письменности

- От клинописи до печатного станка

- От Гутенберга до лампы

- От перфокарт и магнитных лент к современным ЦОДам

Хранение данных. Или что такое NAS, SAN и прочие умные сокращения простыми словами

TL;DR: Вводная статья с описанием разных вариантов хранения данных. Будут рассмотрены принципы, описаны преимущества и недостатки, а также предпочтительные варианты использования.

Зачем это все?

Хранение данных — одно из важнейших направлений развития компьютеров, возникшее после появления энергонезависимых запоминающих устройств. Системы хранения данных разных масштабов применяются повсеместно: в банках, магазинах, предприятиях. По мере роста требований к хранимым данным растет сложность хранилищ данных.

Надежно хранить данные в больших объемах, а также выдерживать отказы физических носителей — весьма интересная и сложная инженерная задача.

Хранение данных

Под хранением обычно понимают запись данных на некоторые накопители данных, с целью их (данных) дальнейшего использования. Опустим исторические варианты организации хранения, рассмотрим подробнее классификацию систем хранения по разным критериям. Я выбрал следующие критерии для классификации: по способу подключения, по типу используемых носителей, по форме хранения данных, по реализации.

По способу подключения есть следующие варианты:

- Внутреннее. Сюда относятся классическое подключение дисков в компьютерах, накопители данных устанавливаются непосредственно в том же корпусе, где и будут использоваться. Типовые шины для подключения — SATA, SAS, из устаревших — IDE, SCSI.

подключение дисков в сервере

- Внешнее. Подразумевается подключение накопителей с использованием некоторой внешней шины, например FC, SAS, IB, либо с использованием высокоскоростных сетевых карт.

дисковая полка, подключаемая по FC

По типу используемых накопителей возможно выделить:

- Дисковые. Предельно простой и вероятно наиболее распространенный вариант до сих пор, в качестве накопителей используются жесткие диски

- Ленточные. В качестве накопителей используются запоминающие устройства с носителем на магнитной ленте. Наиболее частое применение — организация резервного копирования.

- Flash. В качестве накопителей применяются твердотельные диски, они же SSD. Наиболее перспективный и быстрый способ организации хранилищ, по емкости SSD уже фактически сравнялись с жесткими дисками (местами и более емкие). Однако по стоимости хранения они все еще дороже.

- Гибридные. Совмещающие в одной системе как жесткие диски, так и SSD. Являются промежуточным вариантом, совмещающим достоинства и недостатки дисковых и flash хранилищ.

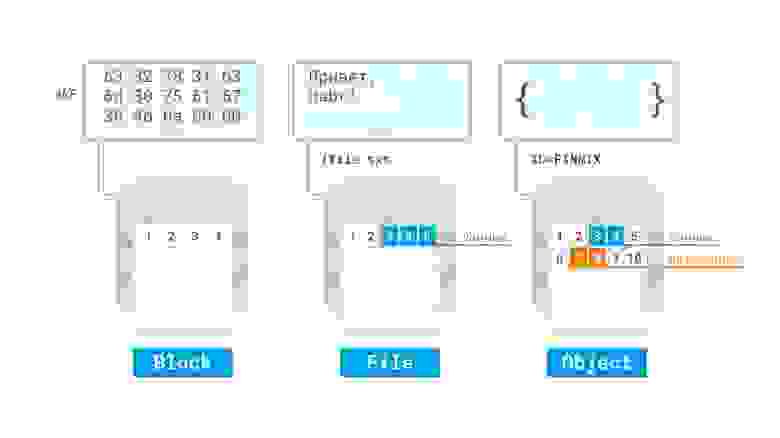

Если рассматривать форму хранения данных, то явно выделяются следующие:

- Файлы (именованные области данных). Наиболее популярный тип хранения данных — структура подразумевает хранение данных, одинаковое для пользователя и для накопителя.

- Блоки. Одинаковые по размеру области, при этом структура данных задается пользователем. Характерной особенностью является оптимизация скорости доступа за счет отсутствия слоя преобразования блоки-файлы, присутствующего в предыдущем способе.

- Объекты. Данные хранятся в плоской файловой структуре в виде объектов с метаданными.

По реализации достаточно сложно провести четкие границы, однако можно отметить:

- аппаратные, например RAID и HBA контроллеры, специализированные СХД.

RAID контроллер от компании Fujitsu

- Программные. Например реализации RAID, включая файловые системы (например, BtrFS), специализированные сетевые файловые системы (NFS) и протоколы (iSCSI), а также SDS

пример организации LVM с шифрованием и избыточностью в виртуальной машине Linux в облаке Azure

Давайте рассмотрим более детально некоторые технологии, их достоинства и недостатки.

Direct Attached Storage — это исторически первый вариант подключения носителей, применяемый до сих пор. Накопитель, с точки зрения компьютера, в котором он установлен, используется монопольно, обращение с накопителем происходит поблочно, обеспечивая максимальную скорость обмена данными с накопителем с минимальными задержками. Также это наиболее дешевый вариант организации системы хранения данных, однако не лишенный своих недостатков. К примеру если нужно организовать хранение данных предприятия на нескольких серверах, то такой способ организации не позволяет совместное использование дисков разных серверов между собой, так что система хранения данных будет не оптимальной: некоторые сервера будут испытывать недостаток дискового пространства, другие же — не будут полностью его утилизировать:

Конфигурации систем с единственным накопителем применяются чаще всего для нетребовательных нагрузок, обычно для домашнего применения. Для профессиональных целей, а также промышленного применения чаще всего используется несколько накопителей, объединенных в RAID-массив программно, либо с помощью аппаратной карты RAID для достижения отказоустойчивости и\или более высокой скорости работы, чем единичный накопитель. Также есть возможность организации кэширования наиболее часто используемых данных на более быстром, но менее емком твердотельном накопителе для достижения и большой емкости и большой скорости работы дисковой подсистемы компьютера.

Storage area network, она же сеть хранения данных, является технологией организации системы хранения данных с использованием выделенной сети, позволяя таким образом подключать диски к серверам с использованием специализированного оборудования. Так решается вопрос с утилизацией дискового пространства серверами, а также устраняются точки отказа, неизбежно присутствующие в системах хранения данных на основе DAS. Сеть хранения данных чаще всего использует технологию Fibre Channel, однако явной привязки к технологии передачи данных — нет. Накопители используются в блочном режиме, для общения с накопителями используются протоколы SCSI и NVMe, инкапсулируемые в кадры FC, либо в стандартные пакеты TCP, например в случае использования SAN на основе iSCSI.

Давайте разберем более детально устройство SAN, для этого логически разделим ее на две важных части, сервера с HBA и дисковые полки, как оконечные устройства, а также коммутаторы (в больших системах — маршрутизаторы) и кабели, как средства построения сети. HBA — специализированный контроллер, размещаемый в сервере, подключаемом к SAN. Через этот контроллер сервер будет «видеть» диски, размещаемые в дисковых полках. Сервера и дисковые полки не обязательно должны размещаться рядом, хотя для достижения высокой производительности и малых задержек это рекомендуется. Сервера и полки подключаются к коммутатору, который организует общую среду передачи данных. Коммутаторы могут также соединяться с собой с помощью межкоммутаторных соединений, совокупность всех коммутаторов и их соединений называется фабрикой. Есть разные варианты реализации фабрики, я не буду тут останавливаться подробно. Для отказоустойчивости рекомендуется подключать минимум две фабрики к каждому HBA в сервере (иногда ставят несколько HBA) и к каждой дисковой полке, чтобы коммутаторы не стали точкой отказа SAN.

Недостатками такой системы являются большая стоимость и сложность, поскольку для обеспечения отказоустойчивости требуется обеспечить несколько путей доступа (multipath) серверов к дисковым полкам, а значит, как минимум, задублировать фабрики. Также в силу физических ограничений (скорость света в общем и емкость передачи данных в информационной матрице коммутаторов в частности) хоть и существует возможность неограниченного подключения устройств между собой, на практике чаще всего есть ограничения по числу соединений (в том числе и между коммутаторами), числу дисковых полок и тому подобное.

Network attached storage, или сетевое файловое хранилище, представляет дисковые ресурсы в виде файлов (или объектов) с использованием сетевых протоколов, например NFS, SMB и прочих. Принципиально базируется на DAS, но ключевым отличием является предоставление общего файлового доступа. Так как работа ведется по сети — сама система хранения может быть сколько угодно далеко от потребителей (в разумных пределах разумеется), но это же является и недостатком в случае организации на предприятиях или в датацентрах, поскольку для работы утилизируется полоса пропускания основной сети — что, однако, может быть нивелировано с использованием выделенных сетевых карт для доступа к NAS. Также по сравнению с SAN упрощается работа клиентов, поскольку сервер NAS берет на себя все вопросы по общему доступу и т.п.

Unified storage

Универсальные системы, позволяющие совмещать в себе как функции NAS так и SAN. Чаще всего по реализации это SAN, в которой есть возможность активировать файловый доступ к дисковому пространству. Для этого устанавливаются дополнительные сетевые карты (или используются уже существующие, если SAN построена на их основе), после чего создается файловая система на некотором блочном устройстве — и уже она раздается по сети клиентам через некоторый файловый протокол, например NFS.

Software-defined storage — программно определяемое хранилище данных, основанное на DAS, при котором дисковые подсистемы нескольких серверов логически объединяются между собой в кластер, который дает своим клиентам доступ к общему дисковому пространству.

Наиболее яркими представителями являются GlusterFS и Ceph, но также подобные вещи можно сделать и традиционными средствами (например на основе LVM2, программной реализации iSCSI и NFS).

N.B. редактора: У вас есть возможность изучить технологию сетевого хранилища Ceph, чтобы использовать в своих проектах для повышения отказоустойчивости, на нашем практическим курсе по Ceph. В начале курса вы получите системные знания по базовым понятиям и терминам, а по окончании научитесь полноценно устанавливать, настраивать и управлять Ceph. Детали и полная программа курса здесь.

Пример SDS на основе GlusterFS

Из преимуществ SDS — можно построить отказоустойчивую производительную реплицируемую систему хранения данных с использованием обычного, возможно даже устаревшего оборудования. Если убрать зависимость от основной сети, то есть добавить выделенные сетевые карты для работы SDS, то получается решение с преимуществами больших SAN\NAS, но без присущих им недостатков. Я считаю, что за подобными системами — будущее, особенно с учетом того, что быстрая сетевая инфраструктура более универсальная (ее можно использовать и для других целей), а также дешевеет гораздо быстрее, чем специализированное оборудование для построения SAN. Недостатком можно назвать увеличение сложности по сравнению с обычным NAS, а также излишней перегруженностью (нужно больше оборудования) в условиях малых систем хранения данных.

Гиперконвергентные системы

Подавляющее большинство систем хранения данных используется для организации дисков виртуальных машин, при использовании SAN неизбежно происходит удорожание инфраструктуры. Но если объединить дисковые системы серверов с помощью SDS, а процессорные ресурсы и оперативную память с помощью гипервизоров отдавать виртуальным машинам, использующим дисковые ресурсы этой SDS — получится неплохо сэкономить. Такой подход с тесной интеграцией хранилища совместно с другими ресурсами называется гиперконвергентностью. Ключевой особенностью тут является способность почти бесконечного роста при нехватке ресурсов, поскольку если не хватает ресурсов, достаточно добавить еще один сервер с дисками к общей системе, чтобы нарастить ее. На практике обычно есть ограничения, но в целом наращивать получается гораздо проще, чем чистую SAN. Недостатком является обычно достаточно высокая стоимость подобных решений, но в целом совокупная стоимость владения обычно снижается.

Облака и эфемерные хранилища

Логическим продолжением перехода на виртуализацию является запуск сервисов в облаках. В предельном случае сервисы разбиваются на функции, запускаемые по требованию (бессерверные вычисления, serverless). Важной особенностью тут является отсутствие состояния, то есть сервисы запускаются по требованию и потенциально могут быть запущены столько экземпляров приложения, сколько требуется для текущей нагрузки. Большинство поставщиков (GCP, Azure, Amazon и прочие) облачных решений предлагают также и доступ к хранилищам, включая файловые и блочные, а также объектные. Некоторые предлагают дополнительно облачные базы, так что приложение, рассчитанное на запуск в таком облаке, легко может работать с подобными системами хранения данных. Для того, чтобы все работало, достаточно оплатить вовремя эти услуги, для небольших приложений поставщики вообще предлагают бесплатное использование ресурсов в течение некоторого срока, либо вообще навсегда.

Из недостатков: могут заблокировать аккаунт, на котором все работает, что может привести к простоям в работе. Также могут быть проблемы со связностью и\или доступностью таких сервисов по сети, поскольку такие хранилища полностью зависят от корректной и правильной работы глобальной сети.

Заключение

Надеюсь, статья была полезной не только новичкам. Предлагаю обсудить в комментариях дополнительные возможности систем хранения данных, написать о своем опыте построения систем хранения данных.

Источник

Обработка и хранение данных: от древности до ЦОДов

Наше время часто называют информационным веком. Однако информация была критически важна для рода человеческого на протяжении всего его существования. Человек никогда не был самым быстрым, самым сильным и выносливым животным. Своим положением в пищевой цепи мы обязаны двум вещам: социальности и способности передавать информацию более чем через одно поколение.

То, как информация хранилась и распространялась сквозь века, продолжает оставаться буквально вопросом жизни и смерти: от выживания племени и сохранения рецептов традиционной медицины до выживания вида и обработки сложных климатических моделей.

Посмотрите на инфографику (кликабельна для просмотра в полной версии). Она отображает эволюцию устройств хранения данных, и масштабы действительно впечатляют. Однако эта картинка далека от совершенства — она охватывает каких-то несколько десятилетий истории человечества, уже живущего в информационном обществе. А между тем данные накапливались, транслировались и хранились с того момента, откуда нам известна история человечества. Сперва это была обычная человеческая память, а в недалёком будущем мы уже ждём хранения данных в голографических слоях и квантовых системах. На Хабре уже неоднократно писали про историю магнитных накопителей, перфокарты и диски размером с дом. Но ещё ни разу не было проделано путешествие в самое начало, когда не было железных технологий и понятия данных, но были биологические и социальные системы, которые научились накапливать, сохранять, транслировать информацию. Попробуем сегодня прокрутить всю историю в рамках одного поста.

Источник изображения: Flickr

До изобретения письменности

До того, как появилось то, что можно без сомнения назвать письменностью, основным способом сохранить важные факты была устная традиция. В такой форме передавались социальные обычаи, важные исторические события, личный опыт или творчество рассказчика. Эту форму сложно переоценить, она продолжала процветать вплоть до средних веков, далеко после появления письменности. Несмотря на неоспоримую культурную ценность, устная форма — эталон неточности и искажений. Представьте себе игру в «испорченный телефон», в которую люди играют на протяжении нескольких столетий. Ящерицы превращаются в драконов, люди обретают песьи головы, а достоверную информацию о быте и нравах целых народностей невозможно отличить от мифов и легенд.

Боян

От клинописи до печатного станка

Для большинства историков рождении цивилизации с большой буквы неотрывно связано с появлением письменности. Согласно распространенным теориям, цивилизация в современном ее понимании появляется в результате создания излишков пищи, разделения труда и появления торговли. В долине Тигра и Евфрата произошло именно это: плодородные поля дали почву торговле, а коммерция, в отличии от эпоса, требует точности. Было это примерно в 2700 г. до нашей эры, то есть 4700 лет назад. Львиная доля шумерских табличек с клинописью заполнены бесконечным рядом торговых транзакций. Не все, конечно, так банально, например, расшифровка шумерской клинописи сохранила для нас старейшую на данный момент литературную работу — «Эпос о Гильгамеше».

Глиняная табличка с клинописью

Клинопись, определенно, была отличным изобретением. Глиняные таблички неплохо сохранились, что уж говорить о клинописи, выбитой на камне. Но у клинописи есть однозначный минус — скорость, и физический (не в мегабайтах) вес итоговых «документов». Представьте, что вам нужно срочно написать и доставить несколько счетов в соседний город. С глиняными табличками такая работа может стать в буквальном смысле неподъемной.

Во многих странах, от Египта до Греции, человечество искало способы быстро, удобно и надежно фиксировать информацию. Все больше люди приходили к той или иной вариации тонких листов органического происхождения и контрастных «чернил». Это решало проблему с со скоростью и, так сказать, «емкостью» на килограмм веса. Благодаря пергаменту, папирусу и, в конечном счете, бумаге человечество получило свою первую информационную сеть: почту.

Однако, с новыми преимуществами пришли новые проблемы: все, что написано на материалах органического происхождения имеет свойство разлагаться, выцветать, да и просто гореть. В эпоху от темных веков вплоть до изобретения печатного пресса большим и важным делом было копирование книг: буквальное переписывание набело, буква за буквой. Если представить сложность и трудоемкость этого процесса, легко понять, почему чтение и письмо оставались привилегией очень узкой прослойки монашества и знатных людей. Однако в середине пятнадцатого века произошло то, что можно назвать Первой Информационной Революцией.

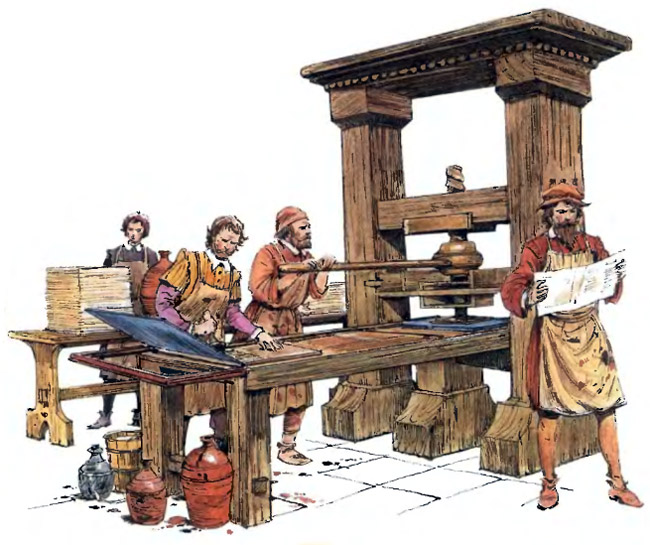

От Гутенберга до лампы

Попытки упростить и ускорить набор текста с помощью комплектов заранее отлитых словоформ или букв и ручного пресса предпринимали еще в Китае в 11 веке. Почему же мы мало знаем об этом и привыкли считать родиной печати Европу? Распространению наборной печати в Китае помешала их собственная сложная письменность. Производство литер для полноценной печати на китайском было слишком трудоемким.

Благодаря Гутенбергу же, у книг появилось понятие экземпляра. Библия Гутенберга была отпечатана 180 раз. 180 копий текста, и каждая копия повышает вероятность, что пожары, наводнения, ленивые переписчики, голодные грызуны не будут помехой для будущих поколений читателей.

Печатный станок Гутенберга

Ручной пресс и ручной подбор литер, однако, не являются, конечно, оптимальным по скорости и трудозатратам процессом. С каждым столетием человеческое общество стремилось не только найти способ сохранить информацию, но и распространить ее как можно более широкому кругу лиц. С развитием технологий, эволюционировала как печать, так и производство копий.

Ротационная печатная машина была изобретена в конце девятнадцатого века, и ее вариации используются вплоть до сегодняшнего дня. Эти махины, с непрерывно вращающимися валами, на которых закреплены печатные формы, были квинтэссенцией индустриального подхода и символизировали очень важный этап в информационном развитии человечества: информация стала массовой, благодаря газетам, листовкам и подешевевшим книгам.

Массовость, однако, не всегда идет на пользу конкретному кусочку информации. Основной носитель, бумага и чернила, все так же подвержены износу, ветхости, утере. Библиотеки, полные книг по всем возможным областям человеческих знаний, становились все более объемны, занимая огромные пространства и требуя все больше ресурсов для своего обслуживания, каталогизации и поиска.

Очередной сдвиг парадигмы в сфере хранения информации произошел после изобретения фотопроцесса. Нескольким инженерам пришла в голову светлая мысль, что миниатюрные фотокопии технических документов, статей и даже книг могут продлить исходникам жизнь и сократить необходимое для их хранения место. Получившиеся в результате подобного мыслительного процесса микрофильмы (миниатюрные фотографии и оборудование для их просмотра) вошли в обиход в финансовых, технических и научных кругах в 20-х годах двадцатого века. У микрофильма много плюсов — этот процесс сочетает в себе легкость копирования и долговечность. Казалось, что развитие способов хранения информации достигло своего апогея.

Микроплёнка, используется до сих пор

От перфокарт и магнитных лент к современным ЦОДам

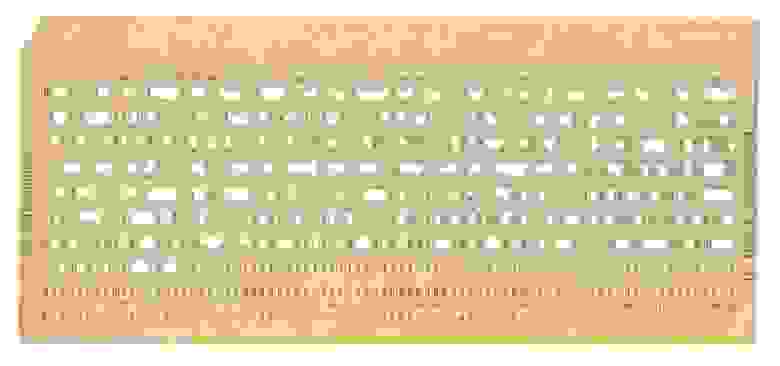

Инженерные умы пытались придумать универсальный метод обработки и хранения информации еще с 17-го века. Блез Паскаль, в частности, заметил, что если вести вычисления в двоичной системе счисления, то математические закономерности позволяют привести решения задач в такой вид, который делает возможным создание универсальной вычислительной машины. Его мечта о такой машине осталась лишь красивой теорией, однако, спустя века, в середине 20-го века, идеи Паскаля воплотились в железе и породили новую информационную революцию. Некоторые считают, что она все еще продолжается.

То, что сейчас принято называть «аналоговыми» методами хранения информации, подразумевает, что для звука, текста, изображений и видео использовались свои технологии фиксации и воспроизведения. Компьютерная память же универсальна — все, что может быть записано, выражается с помощью нулей и единиц и воспроизводится с помощью специализированных алгоритмов. Самый первый способ хранения цифровой информации не отличался ни удобством, ни компактностью, ни надежностью. Это были перфокарты, простые картонки с дырками в специально отведенных местах. Гигабайт такой «памяти» мог весить до 20 тонн. В такой ситуации сложно было говорить о грамотной систематизации или резервном копировании.

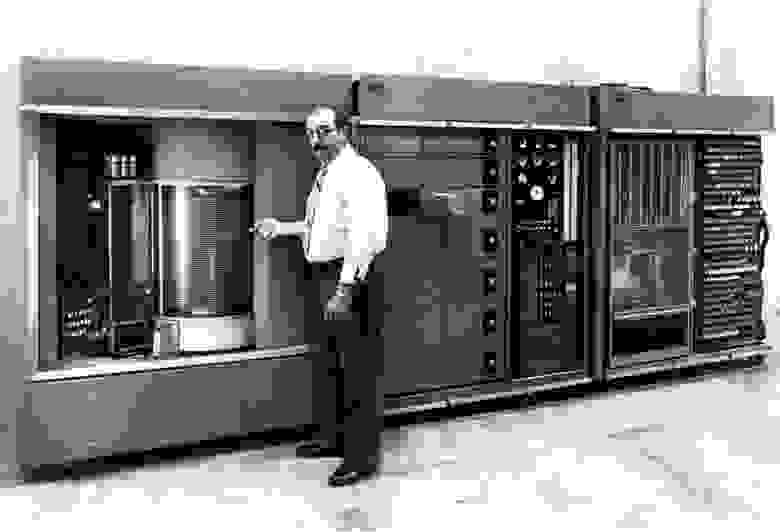

Компьютерная индустрия развивалась стремительно и быстро проникала во все возможные области человеческой деятельности. В 50-х годах инженеры «позаимствовали» запись данных на магнитную ленту у аналоговой аудио и видеозаписи. Стримеры с кассетами объемом до 80 Мб использовались для хранения и резервного копирования данных вплоть до 90-х годов. Это был неплохой способ с относительно продолжительным сроком хранения (до 50 лет) и небольшим размером носителя? Кроме того, удобство их использования и стандартизация форматов хранения данных ввела понятие резервного копирования в бытовой обиход.

Один из первых жёстких дисков IBM, 5 МБ

У магнитных лент и систем, связанных с ними, есть один серьезный недостаток — это последовательный доступ к данным. То есть, чем дальше запись находится от начала ленты, тем больше времени потребуется для того, чтобы ее прочитать.

В 70-х годах 20-го века был произведен первый «жесткий диск» (HDD) в том формате, в котором он знаком нам сегодня — комплект из нескольких дисков с намагничивающимся материалом и головками для чтения/записи. Вариации этой технологии используются и сегодня, постепенно уступая в популярности твердотельным накопителям (SSD). Начиная с этого момента, в течении всего компьютерного бума 80-х формируются основные парадигмы хранения, защиты и резервного копирования информации. Благодаря массовому распространению бытовых и офисных компьютеров, не обладающих большим объемом памяти и вычислительной мощности, укрепилась модель «клиент-сервер». По началу «сервера» были по большей части локальными, своими для каждой организации, института или фирмы. Не было какой-то системы, правил, информация дублировалась в основном на дискеты или магнитные ленты.

Появление интернета, однако, подстегнуло развитие систем хранения и обработки данных. В 90-х годах, на заре «пузыря доткомов» начали появляться первые дата-центры, или ЦОД-ы (центры обработки данных). Требования к надежности и доступности цифровых ресурсов росли, вместе с ними росла сложность их обеспечения. Из специальных комнат в глубине предприятия или института дата-центры превратились в отдельные здания со своей хитрой инфраструктурой. В то же время, у ЦОД-ов кристаллизовалась своего рода анатомия: сами компьютеры (серверы), системы связи с интернет-провайдерами и все, что касается инженерных коммуникаций (охлаждение, системы пожаротушения и физического доступа в помещения).

Чем ближе к сегодняшнему дню, тем больше мы зависим от данных, хранящихся где-то в «облаках» ЦОД-ов. Банковские системы, электронная почта, онлайн-энциклопедии и поисковые движки — все это стало новым стандартом жизни, можно сказать, физическим продолжением нашей собственной памяти. То, как мы работаем, отдыхаем и даже лечимся, всему этому можно навредить простой утерей или даже временным отключением от сети. В двухтысячных годах были разработаны стандарты надежности дата центров, от 1-го до 4-го уровня.

Тогда же из космической и медицинской отраслей начали активно проникать технологии резервирования. Конечно, копировать и размножать информацию с тем, чтобы защитить ее в случае уничтожения оригинала люди умели давно, но именно дублирование не только носителей данных, но и различных инженерных систем, а также необходимость предусматривать точки отказала и возможных человеческих ошибок отличает серьезные ЦОДы. Например, ЦОД, принадлежащий к Tier I будет лишь ограниченную избыточность хранения данных. В требования к Tier II уже прописано резервирование источников питания и наличие защиты от элементарных человеческих ошибок, а Tier III предусматривает резервирование всех инженерных систем и защиту от несанкционированного проникновения. Наконец, высший уровень надежности ЦОДа, четвертый, требует дополнительное дублирование всех резервных систем и полное отсутствие точек отказа. Кратность резервирования (сколько именно резервных элементов приходится на каждый основной) обычно обозначается буквой M. Со временем требования к кратности резервирования только росли.

Построить ЦОД уровня надежности TIER-III, — это проект, с которым справится только исключительно квалифицированная компания. Такой уровень надежности и доступности означает, что, как инженерные коммуникации, так и системы связи дублированы, и дата-центр имеет право на простой только в количестве около 90 минут в год.

У нас в Safedata такой опыт есть: в январе 2014 года в рамках сотрудничества с Российским Научным Центром «Курчатовский Институт» нами был введен в эксплуатацию второй дата-центр SAFEDATA — Москва-II, который также отвечает требованиям уровня TIER 3 стандарта TIA-942, ранее же (2007-2010) мы построили дата-центр Москва-I, который отвечает требованиям уровня TIER 3 стандарта TIA-942 и относится к категории центров хранения и обработки данных с защищенной сетевой инфраструктурой.

Мы видим, что в IT происходит еще одна смена парадигмы, и связана она с data science. Обработка и хранение больших объемов данных становятся актуальны как никогда. В каком-то смысле, любой бизнес должен быть готов стать немного учеными: вы собираете огромное количество данных о ваших клиентах, обрабатываете их и получаете для себя новую перспективу. Для реализации таких проектов потребуется аренда большого количества мощных серверных машин и эксплуатация будет не самой дешевой. Либо, возможно, ваша внутренняя ИТ-система настолько сложна, что на поддержание ее уходит слишком много ресурсов компании.

В любом случае, для каких бы целей вам не понадобились значительные вычислительные мощности, у нас есть услуга «Виртуального ЦОДа». Инфраструктура как сервис — не новое направление, однако мы выгодно отличаемся целостным подходом, начиная от специфически ИТ-шных проблем, вроде переноса корпоративных ресурсов в «Виртуальный ЦОД», до юридических, таких как консультация по актуальному законодательству РФ в сфере защиты данных.

Развитие информационных технологий похоже на беспощадно несущийся вперед поезд, не все успевают запрыгнуть в вагон когда им предоставляется возможность. Где-то до сих пор используют бумажные документы, в старых архивах хранятся сотни не оцифрованных микрофильмов, государственные органы могут до сих пор использовать дискеты. Прогресс никогда не бывает линейно-равномерным. Никто не знает, сколько важных вещей мы в результате навсегда потеряли и какое количество часов было потрачено из-за до сих пор не вполне оптимальных процессов. Зато мы в Safedata знаем, как не допустить пустых трат и невосполнимых потерь конкретно в вашем случае.

Источник