- Инструменты и методы наукометрии на службе оценки научных трудов

- Что такое наукометрия?

- Качественные и количественные методы оценки научных трудов

- Как провести количественную оценку научных трудов?

- Достоинства и недостатки наукометрических способов оценки научных трудов

- Наукометрический минимум для ученого: инструменты для оценки деятельности ученых и организаций

Инструменты и методы наукометрии на службе оценки научных трудов

Каждый научный труд проходит тотальную поверку на качество, оценку экспертов. Помимо расчета самых популярных показателей, основанных на анализе цитируемости, оценить роль статьи или работы можно при помощи инструментов наукометрии.

Каждый научный труд проходит тотальную поверку на качество, оценку экспертов. Помимо расчета самых популярных показателей, основанных на анализе цитируемости, оценить роль статьи или работы можно при помощи инструментов наукометрии.

Что такое наукометрия?

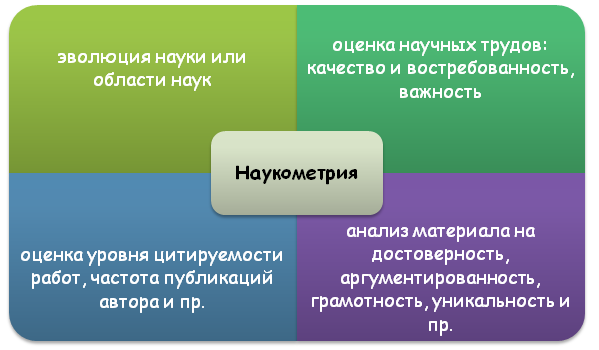

Наукометрия представляет собой особую часть научной мысли, которая позволяет проследить эволюцию конкретного направления или области наук, а также оценить ее роль в развитии человечества, вклад конкретной работы/статьи.

Наукометрия захватывает как качественные, так и количественные методы оценки научных трудов. Если оценивать работы комплексно, то можно получить всестороннюю экспертизу научной мысли. Анализируя же ряд показателей или конкретные материалы работы обособленно, сделать аргументированный вывод о качестве и роли научной работы будет сложно и необъективно.

Качественные и количественные методы оценки научных трудов

Качественные методы наукометрии предполагают «зрительную оценку» материала, которая может проводиться только квалифицированные экспертами (учеными). К данной группе оценки трудов относят:

- Вычитка материалов и выявление ошибок в тексте;

- Анализ текста на логичность, последовательность мысли, аргументированность и достоверность данных;

- Оценка структуры и содержания работы автор;

- Правильность оформления (соответствие ГОСТам и требованиям издательства и пр.).

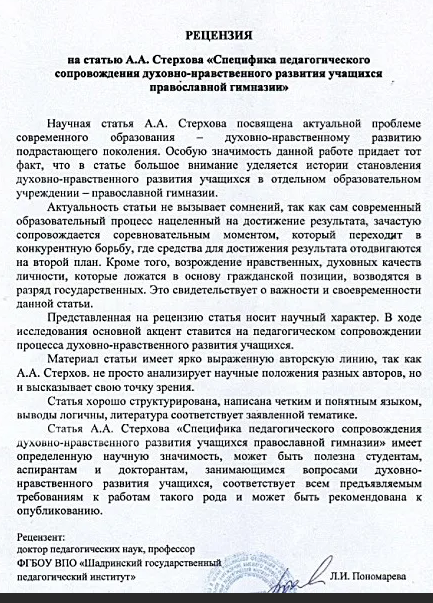

Самым распространенным способом наукометрической качественной оценки научного труда является рецензирование, когда рецензент досконально изучает материал, а затем подчеркивает его достоинства и недостатки, дает собственные рекомендации по его совершенствованию и пр.

Количественные методы оценки научных трудов предполагают расчетов определенных коэффициентов и их анализ. В 90% случаев показатели связаны с понятием цитируемости научных трудов, то есть частотой использования мыслей и работ автора в других исследованиях.

Самыми популярными коэффициентами, используемыми при оценке роли и значимости научных работ, являются:

- Индекс Хирша;

- Импакт-фактор;

- Общее число публикаций автора;

- Количество цитируемых работ автора, количество цитат каждого научного труда исследователя;

- И прочие.

Количественные методы позволяют получить реальные числовые представления о востребованности работ конкретного ученого, получить статистические данные о его деятельности и важности его работ.

Нужна помощь преподавателя?

Мы всегда рады Вам помочь!

Как провести количественную оценку научных трудов?

Количественная оценка роли научных трудов основана на методах математического моделирования. Здесь подсчитываются конкретные данные, сопоставляются, а затем анализируются.

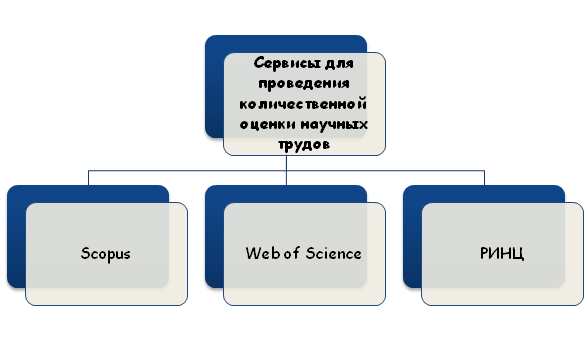

На самом деле узнать количество цитат, сколько раз был заимствован тот или иной фрагмент работы исследователя вручную не удастся. Сделать это можно при помощи специализированных сервисов, которые «отслеживают» каждое копирование, ссылку на ученого и его труд.

Данные сервисы предоставляются такими научными платформами, как Scopus, Web of Science, РИНЦ и пр. Здесь каждый автор или пользователь может просмотреть частоту публикаций и определить уровень цитируемости любого труда. Достаточно вбить в поисковик ключевые слова, данные об авторе или интересующей работе, выбрать походящий пункт и просмотреть рейтинг.

Например, на базе Web of Science есть специальный раздел Essential science indicators, который позволяет получить готовые показатели цитируемости работ за последние 10 лет.

Учтите, что на разных платформах могут анализироваться разные показатели оценки качества и роли научных работ. Период расчета показателей также может разниться.

Достоинства и недостатки наукометрических способов оценки научных трудов

Оценить работу визуально и получить объективную оценку невозможно, чтобы определить значимость статьи, диссертации или иной научной работы, нужно досконально изучить ее, а затем проанализировать и ее качество, и показатели, характеризующие частоту ее использования.

Оценивать проект может только квалифицированные эксперт, разбирающийся в направлении и теме исследования, имеющий ученую степень или звание. Порой найти такого эксперты бывает сложно, но иначе оценить качество материала не удастся.

Количественные методы оценки дают представление о частоте использования трудов конкретного исследователя, оценке его вклада в развитие науки и отрасли и пр. здесь важно учитывать период, захватываемый при расчете показателей. Важно чтобы все показатели захватывали один и тот же период научной деятельности. В противном случае оценить роль ученого и его работ будет невозможно.

Также важно учитывать сферу применения и область науки, к которой относится материал. В одних научных сферах работы цитируются чаще, в других – реже.

Чтобы получить объективную оценку о деятельности ученого и важности его научных мыслей, важно всесторонне анализировать его труды, пользуясь всеми доступными методами и инструментами.

Трудности с учебой?

Помощь в написании студенческих и

аспирантских работ!

Источник

Наукометрический минимум для ученого: инструменты для оценки деятельности ученых и организаций

Наукометрических показателей для оценки труда ученых и организаций существует огромное множество, и многие из них очень соблазняют простотой подсчета. Однако полезным использование таких индикаторов может быть лишь при соблюдении ряда принципиальных условий. С них и начнем.

1. Необходимо учитывать ограничения баз данных, по которым ведется подсчет.Это прежде всего географический, языковой и тематический охват, строгость отбора, учет различных типов источников, качество индексации (наличие задвоений, пропусков и т.д.).

2. Необходимо учитывать различия в практиках публикации и цитирования, характерных для тех наук, представителей которых вы собираетесь сравнивать.

И средняя длина списка литературы, и средний возраст позиций в нем в статьях по математике кардинально отличаются от тех же в молекулярной биологии. Пушкинисты публикуются на русском языке просто потому, что именно на нем говорит большинство профессионалов в этой области. В Computer Science основной канал распространения нового знания и получения признания коллег – доклады на международных конференциях, а не статьи в журналах. В области права ценятся комментарии к законам. И этот перечень особенностей можно продолжать очень долго.

3. Нельзя оценивать по одному «волшебному» индикатору.

Попросту говоря, наука – слишком сложная штука. У нас в распоряжении множество разных «кривых зеркал», которые гораздо лучше использовать в комплексе. Новые хиршеподобные индикаторы появляются в среднем раз в две недели, но внимания на них уже никто из профессионалов не обращает.

4. Наукометрия всегда хуже полноценной экспертизы, проведенной ведущими специалистами по оцениваемой тематике.

Специалисты должны быть не только ведущими, но и лишенными конфликта интересов. Часто говорят, что в России такое невозможно, иностранцев привлекать слишком сложно и т.д. Наш опыт взаимодействия с представителями ведущих мировых научных центров это опровергает. К тому же гуру research evaluation хором учат нас: везде, где только хватает сил и средств, используйте живых экспертов, дополняя, а не подменяя их оценки разнообразными релевантными наукометрическими индикаторами.

5. Нужно заранее тщательно оценивать эффекты от встраивания наукометрии в управление.

Например, если вы усиленно считаете и стимулируете публикации в средних журналах, не удивляйтесь, что доля статей в топовых у вас уменьшится. Проверено Австралией в середине 1990-х. Там тогда действовала примитивная система, когда вузу, по сути, платили за каждую статью в Web of Science вне зависимости от уровня журнала. Число статей выросло, но средний уровень журналов ощутимо упал (http://dx.doi.org/10.1016/S0048-7333(02)00007-0). Есть шанс, что лет через пять это усвоят и в России.

Пример с Австралией взят из Лейденского манифеста об индикаторах науки, опубликованного в этом году в Nature (http://www.nature.com/news/bibliometrics-the-leiden-manifesto-for-research-metrics-1.17351). Этот манифест (набор принципов наподобие изложенных выше) я горячо рекомендую всем и с радостью сделал бы обязательным чтением для всех научных менеджеров, начиная с уровня замдекана по науке и заканчивая президентом. Манифест составлен ключевыми мировыми экспертами по research evaluation и признан всем наукометрическим сообществом.

Теперь о самих показателях.

Число публикаций: обычный и долевой подсчет

Конечно, проще всего оценить результативность научной деятельности ученого или организации по количеству опубликованных работ. Но все не так просто, как кажется, ведь у статьи может быть много авторов, а у каждого автора много аффилиаций. Проще всего использовать так называемый обычный подсчет (whole, или total counting). Написал автор статью в одиночку или в соавторстве с двадцатью коллегами – это все равно одна публикация в его статистике. То же самое верно для организаций и стран: если организация (страна) хотя бы раз указана в списке мест работы авторов статьи, эта публикация считается целиком принадлежащей ей и всем остальным организациям/странам соавторов, все получат за нее по одному очку. Такой подсчет легко приводит к перекосам. Скажем, в статье девять соавторов с экономфака, а десятый работает на экономфаке и факультете компьютерных наук. Оба факультета получат по 1 очку, что, очевидно, не вполне отражает их относительный вклад.

Решение состоит в использовании долевого подсчета (fractional counting). При таком подсчете вся статья «стоит» 1 очко, которое делится поровну между соавторами, а если у соавтора несколько аффилиаций, то его доля делится поровну между ними. В приведенном выше примере экономфак получит 19/20, а ФКН – 1/20. Долевой подсчет применяется как для самих публикаций, так и для полученных ими цитирований, где расхождения с обычным подсчетом могут быть еще более драматическими. Наш отдел считает публикации мегафакультетов и кампусов Вышки обоими способами.

Сейчас к fractional counting под давлением прогрессивной общественности присматриваются коммерческие рейтинги THE и QS, а единственный уважаемый наукометристами Лейденский рейтинг уже вовсю применяет его. Свой вариант долевого подсчета разработало и внедряет Минобрнауки РФ. Правда, вышло очень неоднозначно: очки за публикацию будут делиться только между российскими аффилиациями, а иностранные учитываться не будут. Поэтому статья, где два автора – из МГУ и ВШЭ, принесет этим вузам по 0,5 очка, а статья, где девять авторов из Гарварда, а десятый работает в Гарварде, Стэнфорде и МГУ, принесет нашему вузу полноценное очко. Как результат, вузы и НИИ уже сейчас думают над мерами по сокращению числа внешних российских соавторов в своих статьях. Системные последствия будут очень серьезными.

Обычный подсчет хорошо работает в социально-гуманитарных дисциплинах и математике, где велика доля статей, написанных одним автором, а при работе с публикациями по естественнонаучным дисциплинам лучше применять долевой подсчет, потому что здесь большое количество статей написано в соавторстве. Очевидно, что внутри каждой дисциплины также имеются различия. Например, в физике наибольшее количество соавторов у экспериментаторов в области высоких энергий и частиц. Корректный библиометрический анализ должен учитывать эти особенности. Есть варианты fractional counting, учитывающие роль автора в списке соавторов (corresponding, первый, последний).

Число цитирований

Оценка деятельности ученых на основании одного лишь суммарного числа публикаций способна нанести большой вред науке, особенно если используется как ключевой KPI. Из того, что сильные ученые публикуют много работ, совершенно не следует, что любой автор, опубликовавший много работ, внес серьезный вклад в науку. Одна статья в Nature может стоить тысячи статей в журнале условного третьего квартиля по Scopus, но иногда и на статьи в Nature никто не ссылается. Поэтому при оценке научной деятельности принято опираться на показатели, основанные на суммарном количестве ссылок (цитирований) на публикации данного ученого, подразделения или организации. При этом обычно жестко фиксируют два временных периода: окно публикации (интервал, в течение которого вышли оцениваемые статьи) и окно цитирования (интервал, в течение которого вышли те статьи, ссылки на которые будут учитываться). Чаще всего используют публикационное окно в пять лет и совпадающее с ним окно цитирования. Для бурно развивающихся областей, где знание быстро устаревает (нанотехнологии, биомедицина), временной интервал может быть и меньше пяти лет, а в тех областях, где старение знания происходит сравнительно долго (чистая математика, антиковедение или ботаника), оба окна могут быть увеличены.

Всегда полезно смотреть на число цитирований с исключенным самоцитированием, благо и Scopus, и Web of Science, и РИНЦ предоставляют такую возможность. Вес ссылок тоже имеет значение. Когда на вашу статью в «Экономическом журнале ВШЭ» сослался нобелевский лауреат в American Economic Review, это не совсем то, что ссылка из журнала «Экономист».

Для сравнения ученых из разных областей необходимо использовать нормализованную цитируемость (field-weighted citation impact), учитывающую среднюю цитируемость публикаций данного года выхода данного типа (обзоры цитируются чаще статей) в данной тематике.

Пожалуй, даже более корректный и робастный подход для сравнения представителей различных наук заключается в использовании top10% индикаторов – числа и доли публикаций, попадающих в верхние 10% самых цитируемых в своей области за данный год.

Оценка по уровню журналов

Методики, основанные на цитируемости, имеют серьезный недостаток: надо ждать хотя бы несколько лет, пока эти цитирования успеют накопиться. Для менеджеров это неприемлемо, поэтому все большее распространение получает оценка по уровню журнала, в котором опубликована статья, то есть, по сути, оценка ожидаемой цитируемости. Тут тоже правильнее использовать относительные метрики, прежде всего факт попадания журнала в топ-10% самых цитируемых в своей области по импакт-фактору или SNIP (см. первую часть статьи: http://okna.hse.ru/news/160270181.html). Есть статья в журнале, входящем в топ-10% по импакт-фактору WoS. Значит, она наверняка прошла строгое рецензирование и будет широко читаться. А вот квартили Scopus стоит использовать крайне осторожно (см. Mañana-Rodríguez, J. A critical review of SCImago Journal & Country Rank. Research Evaluation. 2014. http://doi.org/10.1093/reseval/rvu008).

Нельзя не упомянуть, что Сан-францисская декларация по оценке исследований, DORA (http://www.ascb.org/dora/), гласит: не используйте уровень журнала для оценки конкретной публикации и ее автора. Ее подписали 592 организации – от редакций Science и PNAS, Института Говарда Хьюза и ведущих американских и европейских научных обществ до Харьковского педагогического университета. Мы не подписали.

Популярная ныне оценка по совокупному импакт-фактору (сумме значений ИФ отдельных статей, равных ИФ опубликовавших их журналов) для сравнения представителей разных дисциплин не годится: слишком велики различия в средней цитируемости. С оговорками ее допустимо использовать разве что для оценки очень схожих по тематике исследований организаций одинаковых размеров.

H-индекс, g-индекс, m-индекс

Ну вот мы и подошли к волшебной цифре, дарящей иллюзию понимания тысячам научных управленцев. H-индекс был предложен физиком-теоретиком из Калифорнийского университета в Сан-Диего Хорхе Хиршем. Этот показатель призван дать комплексную оценку одновременно числу публикаций и их цитируемости (т.е. количеству и качеству). Кроме того, методика подсчета индекса Хирша намеренно уходит от определения средних величин, средней цитируемости статей.

Индекс Хирша массива публикаций (ученого, организации, страны) равен h, если есть h статей из этого массива, каждая из которых получила не менее h цитирований. Поэтому для высокого индекса нужно иметь много статей, каждая из которых цитировалась много раз. Очень важно учитывать, что h-индекс в интерфейсе WoS включает самоцитирования.

Для ученых часто рассчитывают «пожизненный» индекс Хирша за всю научную карьеру, как это было сделано Х. Хиршем в исходной статье, однако это приводит к очевидному неравенству пожилых и молодых специалистов. Дело в том, что такой показатель не может уменьшаться с течением времени, может только расти или оставаться неизменным. Поэтому для получения сравнимого показателя следует, как и для других библиометрических индикаторов, задать публикационное окно и окно цитирования.

Еще ряд недостатков h-индекса:

· h-индекс не предполагает поправки на дисциплинарную область: сравнение абсолютных значений индекса у ученых, работающих в разных областях науки, невозможно; это не нормализованный по областям науки показатель;

· в индексе не учитывается реальное число ссылок, полученное статьями выше и ниже точки h: важно только местонахождение этой точки. В науке крайне важны высокоцитируемые работы, для их учета гораздо лучше подойдут показатели топ-10% и топ-1%;

· h-индекс не учитывает количество и статус соавторов. Например, у специалистов по физике высоких энергий, публикующих десятки статей в год с сотнями и тысячами соавторов, он может достичь 30-40 уже в молодом возрасте.

m-индекс

Также предложенный Хиршем, этот индекс дает возможность учесть длительность карьеры и рассчитывается как h-index, деленный на число лет с момента первой публикации.

g-индекс

Как говорилось выше, с момента открытия Хирша ученые наплодили сотни вариаций его индекса. Из них сколько-нибудь прижился, пожалуй, только разработанный известным наукометристом Лео Эгге g-индекс. G-индекс набора публикаций равен такому максимальному g, что g наиболее цитируемых статей из этого набора получили в сумме не менее g в квадрате ссылок. На практике g-индекс всегда больше или равен h-индексу.

Другое определение: g-индекс ученого равен такому максимальному g, что у ученого есть g статей со средней цитируемостью на одну статью не менее g.

G-индекс лишен ключевого недостатка, отмеченного для индекса Хирша: он учитывает вклад самых высокоцитируемых работ. Эгге предложил h- и g-индекс с использованием fractional counting, но это уже для мазохистов (http://onlinelibrary.wiley.com/doi/10.1002/asi.20845/abstract).

Чудесно, очень познавательно и совсем не скучно, скажете вы. Но где посмотреть на все эти индексы и нормализованные цитирования по живым людям и организациям? Вышка купила доступ к аналитической надстройке SciVal, где каждый желающий может в пару кликов вывести h-, g- и m-индекс, посчитать нормализованную цитируемость, число и долю публикаций, попавших в топ-10% самых цитируемых в своей области, число и долю публикаций в топ-10% журналов и многое другое. Заходите с компьютеров внутри Вышки на scival.com, регистрируйтесь (это быстро, просто и уже оплачено для всех сотрудников) и чувствуйте себя заправскими наукометристами. Только учтите, что продавать картинки и таблицы из SciVal или массово размещать их в открытом доступе запрещено.

Этот выпуск «Академической среды» целиком, а также все предыдущие выпуски, читайте по этой ссылке в формате PDF

Источник