Сбор и анализ исходных данных

Не всегда этот этап выделяется как самостоятельный, однако выполняемая на этом этапе работа исключительно важна, трудоемка. Если программирование и трассировку имитационной модели можно выполнять на гипотетических данных, то предстоящее экспериментальное исследование необходимо выполнять на реальном потоке данных. От этого зависит во многом точность получаемых результатов моделирования.

Здесь перед разработчиком имитационной модели встают два вопроса: где и каким образом получить, собрать исходную информацию; как обработать собранные данные о реальной системе.

Основные методы получения исходных данных:

из существующей документации на систему (это могут быть данные официальных и других отчетов, статистические сборники, например, для социально-экономических систем, финансовая и техническая документация -для производственных систем и физическое экспериментирование. Часто для задания исходной информации необходимо провести натурные эксперимент на моделируемой системе или ее прототипах (порой это бывают дорогостоящие эксперименты, -однако это плата за то, чтобы получить точную модель, на которой можно в дальнейшем проводить испытания). Такой подход применим для космических, военных исследований, в авиации. В более простых случаях можно проводить измерения, например хронометраж при выполнении производственных операций;

предварительный, априорный синтез данных. Иногда исходные данные могут не существовать, и сама природа моделируемой системы исключает возможность физического экспериментирования (например, проектируемые системы, прогнозирование в социальных и политических исследованиях). В этом случае предлагают различные приемы предварительного синтеза данных. Например, при моделировании информационных систем, продолжительность выполнения информационного требования оценивается на основании трудоемкости реализуемых на ЭВМ алгоритмов. К этим методам относят различные процедуры, основанные на общем анализе проблематики, анкетировании, интервьюировании, широком применении методов экспертного оценивания.

Второй вопрос связан с проблемой идентификации входных данных для стохастических систем. Мы уже говорили о том, что имитационное моделирование является эффективным аппаратом исследования стохастических систем, т.е. таких систем, динамика которых зависит от случайных факторов. Входные (и выходные) переменные стохастической модели, как правило, —случайные величины, векторы, функции, случайные процессы. Поэтому возникают дополнительные трудности, связанные с синтезом уравнений относительно неизвестных законов распределения и определением вероятностных характеристик (средних значений, дисперсий, корреляционных функций и т.п.) для анализируемых процессов и их параметров. Необходимость статистического анализа при сборе и анализе входных данных связана с задачами определения вида функциональных зависимостей, описывающих входные данные, оценкой конкретных значений параметров этих зависимостей, а также проверкой значимости параметров. Для подбора теоретических распределений случайных величин применяют известные методы математической статистики, основанные на определении параметров эмпирических распределений и проверке статистических гипотез, с использованием критериев согласия, о том, согласуются ли имеющиеся эмпирические данные с известными законами распределения (на статистически приемлемом доверительном уровне). Конечно, на вход модели можно подавать и сырые эмпирические данные, однако это неэффективно как с точки зрения программной реализации, так и с точки зрения моделирования, руководствуясь желанием получить более общие и полезные результаты на выходе имитационной модели.

Источник

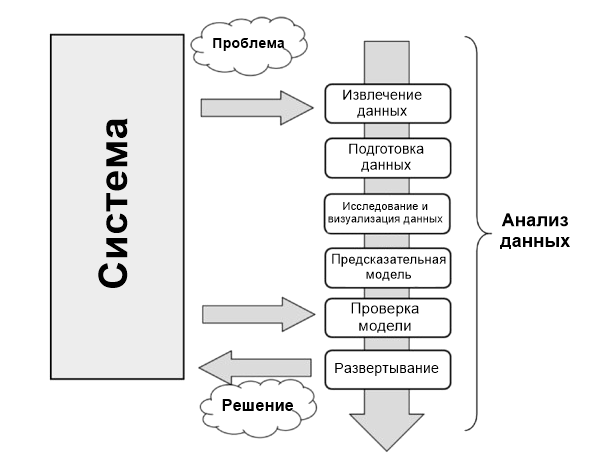

Процесс анализа данных

Анализ данных можно описать как процесс, состоящий из нескольких шагов, в которых сырые данные превращаются и обрабатываются с целью создать визуализации и сделать предсказания на основе математической модели.

Анализ данных — это всего лишь последовательность шагов, каждый из которых играет ключевую роль для последующих. Этот процесс похож на цепь последовательных, связанных между собой этапов:

- Определение проблемы;

- Извлечение данных;

- Подготовка данных — очистка данных;

- Подготовка данных — преобразование данных;

- Исследование и визуализация данных;

- Предсказательная модель;

- Проверка модели, тестирование;

- Развертывание — визуализация и интерпретация результатов;

- Развертывание — развертывание решения.

Определение проблемы

Процесс анализа данных начинается задолго до сбора сырых данных. Он начинается с проблемы, которую необходимо сперва определить, а затем и решить.

Определить ее можно только сосредоточившись на изучаемой системе: механизме, приложении или процессе в целом. Исследование может быть предназначено для лучшего понимания функционирования системы, но его лучше спроектировать так, чтобы понять принципы поведения и впоследствии делать предсказания или выбор (осознанный).

Процессы определения и документации результатов научной проблемы или бизнеса нужны для того, чтобы сосредоточить анализ на получении результатов.

На самом деле, всеобъемлющее и исчерпывающее исследование системы — это сложный процесс, и почти всегда нет достаточного количества информации, с которой можно начать. Поэтому определение проблемы и особенно планирование приводят к появлению руководящих принципов, которым необходимо следовать в течение всего проекта.

Когда проблема определена и задокументирована, можно двигаться к этапу планирования проекта анализа данных. Планирование необходимо для понимания того, какие профессионалы и ресурсы понадобятся для выполнения требований проекта максимально эффективно. Таким образом задача — рассмотреть те вопросы в области, которые касаются решения этой проблемы Необходимо найти специалистов с разными интересами и установить ПО, нужное для анализа данных.

Построение хорошей команды — один из ключевых факторов успешного анализа данных.

Также во время фазы планировки выбирается эффективная команда. Такие команды должны быть междисциплинарными, чтобы у них была возможность решать проблемы, рассматривая данные с разных точек зрения.

Извлечение данных

Когда проблема определена, первый шаг для проведения анализа — получение данных. Они должны быть выбраны с одной базовой целью — построение предсказательной модели. Поэтому выбор данных — также важный момент для успешного анализа.

Данные должны максимально отражать реальный мир — то, как система реагирует на него. Например, использовании больших наборов сырых данных, которые были собраны неграмотно, это привести либо к неудаче, либо к неопределенности.

Поэтому недостаточное внимание, уделенное выбору данных или выбор таких, которые не представляют систему, приведет к тому, что модели не будут соответствовать изучаемым системам.

Поиск и извлечение данных часто требует интуиции, границы которой лежат за пределами технических исследований и извлечения данных. Этот процесс также требует понимания природы и формы данных, предоставить которое может только опыт и знания практической области проблемы.

Вне зависимости от количества и качества необходимых данных важный вопрос — использование лучших источников данных.

Если средой изучения выступает лаборатория (техническая или научная), а сгенерированные данные экспериментальные, то источник данных легко определить. В этом случае речь идет исключительно о самих экспериментах.

Но при анализе данных невозможно воспроизводить системы, в которых данные собираются исключительно экспериментальным путем, во всех областях применения. Многие области требуют поиска данных в окружающем мире, часто полагаясь на внешние экспериментальные данные или даже на сбор их с помощью интервью и опросов.

В таких случаях поиск хорошего источника данных, способного предоставить все необходимые данные, — задача не из легких. Часто необходимо получать данные из нескольких источников данных для устранения недостатков, выявления расхождений и с целью сделать данные максимально общими.

Интернет — хорошее место для начала поиска данных. Но большую часть из них не так просто взять. Не все данные хранятся в виде файла или базы данных. Они могут содержаться в файле HTML или другом формате. Тут на помощь приходит техника парсинга. Он позволяет собирать данные с помощью поиска определенных HTML-тегов на страницах. При появлении таких совпадений специальный софт извлекает нужные данные. Когда поиск завершен, у вас есть список данных, которые необходимо проанализировать.

Подготовка данных

Из всех этапов анализа подготовка данных кажется наименее проблемным шагом, но на самом деле требует наибольшего количества ресурсов и времени для завершения. Данные часто собираются из разных источников, каждый из которых может предлагать их в собственном виде или формате. Их нужно подготовить для процесса анализа.

Подготовка данных включает такие процессы:

- получение,

- очистка,

- нормализация,

- превращение в оптимизированный набор данных.

Обычно это табличная форма, которая идеально подходит для этих методов, что были запланированы на этапе проектировки.

Многие проблемы могут возникнуть при появлении недействительных, двусмысленных или недостающих значений, повторении полей или данных, несоответствующих допустимому интервалу.

Изучение данных/визуализация

Изучение данных — это их анализ в графической или статистической репрезентации с целью поиска моделей или взаимосвязей. Визуализация — лучший инструмент для выделения подобных моделей.

За последние годы визуализация данных развилась так сильно, что стала независимой дисциплиной. Многочисленные технологии используются исключительно для отображения данных, а многие типы отображения работают так, чтобы получать только лучшую информацию из набора данных.

Исследование данных состоит из предварительного изучения, которое необходимо для понимания типа и значения собранной информации. Вместе с информацией, собранной при определении проблемы, такая категоризация определяет, какой метод анализа данных лучше всего подойдет для определения модели.

Эта фаза, в дополнение к изучению графиков, состоит из следующих шагов:

- Обобщение данных;

- Группировка данных;

- Исследование отношений между разными атрибутами;

- Определение моделей и тенденций;

- Построение моделей регрессионного анализа;

- Построение моделей классификации.

Как правило, анализ данных требует обобщения заявлений касательно изучаемых данных.

Обобщение — процесс, при котором количество данных для интерпретации уменьшается без потери важной информации.

Кластерный анализ — метод анализа данных, используемый для поиска групп, объединенных общими атрибутами (также называется группировкой).

Еще один важный этап анализа — идентификация отношений, тенденций и аномалий в данных. Для поиска такой информации часто нужно использовать инструменты и проводить дополнительные этапы анализа, но уже на визуализациях.

Другие методы поиска данных, такие как деревья решений и ассоциативные правила, автоматически извлекают важные факты или правила из данных. Эти подходы используются параллельно с визуализацией для поиска взаимоотношений данных.

Предсказательная (предиктивная) модель

Предсказательная аналитика — это процесс в анализе данных, который нужен для создания или поиска подходящей статистической модели для предсказания вероятности результата.

После изучения данных у вас есть вся необходимая информация для развития математической модели, которая кодирует отношения между данными. Эти модели полезны для понимания изучаемой системы и используются в двух направлениях.

Первое — предсказания о значениях данных, которые создает система. В этом случае речь идет о регрессионных моделях.

Второе — классификация новых продуктов. Это уже модели классификации или модели кластерного анализа. На самом деле, можно разделить модели в соответствии с типом результатов, к которым те приводят:

- Модели классификации: если полученный результат — качественная переменная.

- Регрессионные модели: если полученный результат числовой.

- Кластерные модели: если полученный результат описательный.

Простые методы генерации этих моделей включают такие техники:

- линейная регрессия,

- логистическая регрессия,

- классификация,

- дерево решений,

- метод k-ближайших соседей.

Но таких методов много, и у каждого есть свои характеристики, которые делают их подходящими для определенных типов данных и анализа. Каждый из них приводит к появлению определенной модели, а их выбор соответствует природе модели продукта.

Некоторые из методов будут предоставлять значения, относящиеся к реальной системе и их структурам. Они смогут объяснить некоторые характеристики изучаемой системы простым способом. Другие будут делать хорошие предсказания, но их структура будет оставаться «черным ящиком» с ограниченной способностью объяснить характеристики системы.

Проверка модели

Проверка (валидация) модели, то есть фаза тестирования, — это важный этап. Он позволяет проверить модель, построенную на основе начальных данных. Он важен, потому что позволяет узнать достоверность данных, созданных моделью, сравнив их с реальной системой. Но в этот раз вы берете за основу начальные данные, которые использовались для анализа.

Как правило, при использовании данных для построения модели вы будете воспринимать их как тренировочный набор данных (датасет), а для проверки — как валидационный набор данных.

Таким образом сравнивая данные, созданные моделью и созданные системой, вы сможете оценивать ошибки. С помощью разных наборов данных оценивать пределы достоверности созданной модели. Правильно предсказанные значения могут быть достоверны только в определенном диапазоне или иметь разные уровни соответствия в зависимости от диапазона учитываемых значений.

Этот процесс позволяет не только в числовом виде оценивать эффективность модели, но также сравнивать ее с другими. Есть несколько подобных техник; самая известная — перекрестная проверка (кросс-валидация). Она основана на разделении учебного набора на разные части. Каждая из них, в свою очередь, будет использоваться в качестве валидационного набора. Все остальные — как тренировочного. Так вы получите модель, которая постепенно совершенствуется.

Развертывание (деплой)

Это финальный шаг процесса анализа, задача которого — предоставить результаты, то есть выводы анализа. В процессе развертывания бизнес-среды анализ является выгодой, которую получит клиент, заказавший анализ. В технической или научной средах результат выдает конструкционные решения или научные публикации.

Развертывание — это процесс использования на практике результатов анализа данных.

Есть несколько способов развертывания результатов анализа данных или майнинга данных. Обычно развертывание состоит из написания отчета для руководства или клиента. Этот документ концептуально описывает полученные результаты. Он должен быть направлен руководству, которое будет принимать решения. Затем оно использует выводы на практике.

В документации от аналитика должны быть подробно рассмотрены следующие темы:

- Результаты анализа;

- Развертывание решения;

- Анализ рисков;

- Измерения влияния на бизнес.

Когда результаты проекта включают генерацию предсказательных моделей, они могут быть использованы в качестве отдельных приложений или встроены в ПО.

Источник