- Ковариация

- Корреляция

- Ковариация | Covariance

- Интерпретация ковариации

- 1.3. Основные правила расчета ковариации.

- 1.4. Теоретическая ковариация.

- Корреляция, ковариация и девиация (часть 3)

- 7. Векторизация и нормирование одномерных координат

- 8. Векторизация и ортонормирование многомерных координат

- 9. Матрица Грина — это матрица корреляции векторов

Ковариация

Ковариацией $cov\left(X,\ Y\right)$ случайных величин $X$ и $Y$ называется математическое ожидание произведения случайных величин $X-M\left(X\right)$ и $Y-M\left(Y\right)$, то есть:

Бывает удобно вычислять ковариацию случайных величин $X$ и $Y$ по следующей формуле:

которая может быть получена из первой формулы, используя свойства математического ожидания. Перечислим основные свойства ковариации.

1. Ковариация случайной величины с самой собой есть ее дисперсия.

2. Ковариация симметрична.

$$cov\left(X,\ Y\right)=cov\left(Y,\ X\right).$$

3. Если случайные величины $X$ и $Y$ независимы, то:

4. Постоянный множитель можно выносить за знак ковариации.

$$cov\left(cX,\ Y\right)=cov\left(X,\ cY\right)=c\cdot cov\left(X,\ Y\right).$$

5. Ковариация не изменится, если к одной из случайных величин (или двум сразу) прибавить постоянную величину:

$$cov\left(X+c,\ Y\right)=cov\left(X,\ Y+c\right)=cov\left(X+x,\ Y+c\right)=cov\left(X,\ Y\right).$$

6. $cov\left(aX+b,\ cY+d\right)=ac\cdot cov\left(X,\ Y\right)$.

8. $\left|cov\left(X,\ Y\right)\right|=\sqrt

9. Дисперсия суммы (разности) случайных величин равна сумме их дисперсий плюс (минус) удвоенная ковариация этих случайных величин:

$$D\left(X\pm Y\right)=D\left(X\right)+D\left(Y\right)\pm 2cov\left(X,\ Y\right).$$

Пример 1. Дана корреляционная таблица случайного вектора $\left(X,\ Y\right)$. Вычислить ковариацию $cov\left(X,\ Y\right)$.

$\begin

\hline

X\backslash Y & -6 & 0 & 3 \\

\hline

-2 & 0,1 & 0 & 0,2 \\

\hline

0 & 0,05 & p_ <22>& 0 \\

\hline

1 & 0 & 0,2 & 0,05 \\

\hline

7 & 0,1 & 0 & 0,1 \\

\hline

\end

События $\left(X=x_i,\ Y=y_j\right)$ образуют полную группу событий, поэтому сумма всех вероятностей $p_

$\begin

\hline

X\backslash Y & -6 & 0 & 3 \\

\hline

-2 & 0,1 & 0 & 0,2 \\

\hline

0 & 0,05 & 0,2 & 0 \\

\hline

1 & 0 & 0,2 & 0,05 \\

\hline

7 & 0,1 & 0 & 0,1 \\

\hline

\end

Пользуясь формулой $p_ =\sum _

$\begin

\hline

X & -2 & 0 & 1 & 7 \\

\hline

p_i & 0,3 & 0,25 & 0,25 & 0,2 \\

\hline

\end

$$M\left(X\right)=\sum^n_

Пользуясь формулой $q_

$$M\left(Y\right)=\sum^n_

Поскольку $P\left(X=-2,\ Y=-6\right)=0,1\ne 0,3\cdot 0,25$, то случайные величины $X,\ Y$ являются зависимыми.

Определим ковариацию $cov\ \left(X,\ Y\right)$ случайных величин $X,\ Y$ по формуле $cov\left(X,\ Y\right)=M\left(XY\right)-M\left(X\right)M\left(Y\right)$. Математическое ожидание произведения случайных величин $X,\ Y$ равно:

$$M\left(XY\right)=\sum_

Тогда $cov\left(X,\ Y\right)=M\left(XY\right)-M\left(X\right)M\left(Y\right)=-1,95-1,05\cdot \left(-0,45\right)=-1,4775.$ Если случайные величины независимы, то их ковариации равна нулю. В нашем случае $cov(X,Y)\ne 0$.

Корреляция

Коэффициентом корреляции случайных величин $X$ и $Y$ называется число:

Перечислим основные свойства коэффициента корреляции.

1. $\rho \left(X,\ X\right)=1$.

2. $\rho \left(X,\ Y\right)=\rho \left(Y,\ X\right)$.

3. $\rho \left(X,\ Y\right)=0$ для независимых случайных величин $X$ и $Y$.

5. $\left|\rho \left(X,\ Y\right)\right|\le 1$.

6. $\left|\rho \left(X,\ Y\right)\right|=1\Leftrightarrow Y=aX+b$.

Ранее было сказано, что коэффициент корреляции $\rho \left(X,\ Y\right)$ отражает степень линейной зависимости между двумя случайными величинами $X$ и $Y$.

При $\rho \left(X,\ Y\right)>0$ можно сделать вывод о том, что с ростом случайной величины $X$ случайная величина $Y$ имеет тенденцию к увеличению. Это называется положительной корреляционной зависимостью. Например, рост и вес человека связаны положительной корреляционной зависимостью.

При $\rho \left(X,\ Y\right) Да Нет

При копировании материала с сайта, обратная ссылка обязательна!

Источник

Ковариация | Covariance

Математически ковариация (англ. Covariance) представляет собой меру линейной зависимости двух случайных величин. В портфельной теории этот показатель используется для определения зависимости между доходностью определенной ценной бумаги и доходностью портфеля ценных бумаг. Чтобы рассчитать ковариацию доходности необходимо воспользоваться следующей формулой:

где ki – доходность ценной бумаги в i-ом периоде;

pi – доходность портфеля в i-ом периоде;

n – количество наблюдений.

Следует отметить, что в знаменатель формулы подставляется (n-1), если ковариация рассчитывается на основании выборки из генеральной совокупности наблюдений. Если в расчетах учитывается вся генеральная совокупность, то в знаменатель подставляется n.

Пример. В таблице представлена динамика доходность акций Компании А и Компании Б, а также динамика доходности портфеля ценных бумаг.

Чтобы воспользоваться вышеприведенной формулой для расчета ковариации доходности каждой из акций с портфелем необходимо рассчитать среднюю доходность, которая составит:

- для акций Компании А 4,986%;

- для акций Компании Б 5,031%;

- для портфеля 3,201%.

Таким образом, ковариация акций Компании А с портфелем составит -0,313, а акций Компании Б 0,242.

Cov (kA, kp) = ((5,93-4,986)(2,27-3,201) + (5,85-4,986)(2,39-3,201) + (5,21-4,986)(3,47-3,201) + (5,37-4,986)(3,21-3,201) + (4,99-4,986)(2,95-3,201) + (4,87-4,986)(2,97-3,201) + (4,70-4,986)(3,32-3,201) + (4,75-4,986)(3,65-3,201) + (4,33-4,986)(3,97-3,201) + (3,86-4,986)(3,81-3,201))/(10-1) = -0,313

Cov (kБ, kp) = ((4,25-5,031)(2,27-3,201) + (4,47-5,031)(2,39-3,201) + (4,68-5,031)(3,47-3,201) + (4,71-5,031)(3,21-3,201) + (4,77-5,031)(2,95-3,201) + (5,25-5,031)(2,97-3,201) + (5,45-5,031)(3,32-3,201) + (5,33-5,031)(3,65-3,201) + (5,55-5,031)(3,97-3,201) + (5,85-5,031)(3,81-3,201))/(10-1) = 0,242

Аналогичные расчеты можно произвести в Microsoft Excel при помощи функции «КОВАРИАЦИЯ.В» для выборки из генеральной совокупности или функции «КОВАРИАЦИЯ.Г» для всей генеральной совокупности.

Интерпретация ковариации

Значение коэффициента ковариации может быть как отрицательным, так и положительным. Его отрицательное значение говорит о том, что доходность ценной бумаги и доходность портфеля демонстрируют разнонаправленное движение. Другими словами, если доходность ценной бумаги будет расти, то доходность портфеля будет падать, и наоборот. Положительное значение свидетельствует о том, что доходность ценной бумаги и портфеля изменяются в одном направлении.

Низкое значение (близкое к 0) коэффициента ковариации наблюдается в том случае, когда колебания доходности ценной бумаги и доходности портфеля носят случайный характер.

Источник

1.3. Основные правила расчета ковариации.

Есть несколько важных правил, которые вытекают непосредственно из определения ковариации.

Если у = а + в, то Cov (x,y ) = Cov (x ,а) + Cov (x , в) 2.

Доказательство правила 1

( x —

Таким образом, мы доказали, что Соv (х,у) является суммой ковариаций Cov (x,a) и Cov (x ,в).

Это правило можно пояснить на следующем примере. Допустим, х — доход семьи, у — расходы на питание и одежду, которые в свою очередь можно разбить на а — расходы на питание и в — расходы на одежду. Тогда, согласно правилу 1, ковариация доходов с общими расходами (у) может быть определена как сумма ковариации доходов с расходами на питание (а) и ковариации доходов с расходами на одежду (в).

Если у = к с, где к — константа, то Cov ( х, у) = к Cov (х,с) 3.

Доказательство правила 2

Cov (x, y) =

Если у = а, где а — константа, то Cov (х,у) = 0. 4.

Доказательство правила 3

Это совсем просто. Поскольку а — константа, то

Пользуясь этими основными правилами, вы можете упрощать значительно более сложные выражения с ковариациями. Например, если какая то переменная равна сумме трех переменных — u , v и w, то, пользуясь правилом 1 и разбив у на две части ( u и v + w ), получим :

Cov (x , y) = Cov (x, u + v + w) = Cov (x, u ) + Cov (x , v + w ) = Cov (x ,u ) + Cov (x , v ) + Cov ( x , w ).

Итак, выборочная ковариация между х и у определяется по формуле 1.1. Другим эквивалентным выражением является

Cov (x, y) =

( доказательство эквивалентности указанных уравнений здесь опускается).

1.4. Теоретическая ковариация.

Если х и у — случайные величины, то теоретическая ковариация ху определяется как математическое ожидание произведения отклонений этих величин от их средних значений :

Если теоретическая ковариация неизвестна, то для ее оценки может быть использована выборочная ковариация, вычисленная по ряду наблюдений. К сожалению, оценка будет иметь отрицательное смещение, так как

Е

Причина заключается в том, что выборочные отклонения измеряются по отношению к выборочным средним значениям величин х и у и имеют тенденцию к занижению отклонений от истинных средних значений. Очевидно , мы можем рассчитать несмещенную оценку путем умножения выборочной оценки на п /п -1. Правила для теоретической ковариации точно такие же, как и для выборочной ковариации, но их доказательства мы опускаем, поскольку для этого требуется интегральное исчисление.

Если х и у независимы, то их теоретическая ковариация равна нулю благодаря свойству независимости и факту , что Е (х) и Е(у) равняются соответственно х и у .

Источник

Корреляция, ковариация и девиация (часть 3)

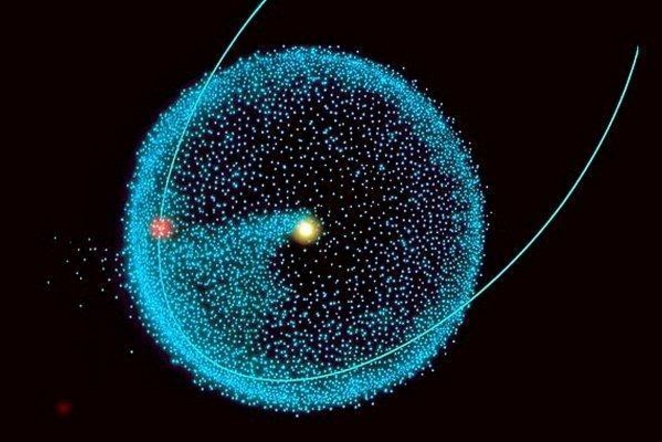

В первой части показано, как на основе матрицы расстояний между элементами получить матрицу Грина. Ее спектр образует собственную систему координат множества, центром которой является центроид набора. Во второй рассмотрены спектры простых геометрических наборов.

В данной статье покажем, что матрица Грина и матрица корреляции — суть одно и то же.

7. Векторизация и нормирование одномерных координат

Пусть значения некой характеристики элементов заданы рядом чисел . Для того, чтобы данный набор можно было сравнивать с другими характеристиками, необходимо его векторизовать и обезразмерить (нормировать).

Для векторизации находим центр (среднее) значений

и строим новый набор как разность между исходными числами и их центроидом (средним):

Получили вектор. Основной признак векторов состоит в том, что сумма их координат равна нулю. Далее нормируем вектор, — приведем сумму квадратов его координат к 1. Для выполнения данной операции нам нужно вычислить эту сумму (точнее среднее):

Теперь можно построить ССК исходного набора как совокупность собственного числа S и нормированных координат вектора:

Квадраты расстояний между точками исходного набора определяются как разности квадратов компонент собственного вектора, умноженные на собственное число. Обратим внимание на то, что собственное число S оказалось равно дисперсии исходного набора (7.3).

Итак, для любого набора чисел можно определить собственную систему координат, то есть выделить значение собственного числа (она же дисперсия) и рассчитать координаты собственного вектора путем векторизации и нормирования исходного набора чисел. Круто.

Упражнение для тех, кто любит «щупать руками». Построить ССК для набора <1, 2, 3, 4>.

8. Векторизация и ортонормирование многомерных координат

Что, если вместо набора чисел нам задан набор векторов — пар, троек и прочих размерностей чисел. То есть точка (узел) задается не одной координатой, а несколькими. Как в этом случае построить ССК? Стандартный путь следующий.

Введем обозначение характеристик (компонент) набора. Нам заданы точки (элементы) и каждой точке соответствует числовое значение характеристики

. Обращаем внимание, что второй индекс

— это номер характеристики (столбцы матрицы), а первый индекс

— номер точки (элемента) набора (строки матрицы).

Далее векторизуем характеристики. То есть для каждой находим центроид (среднее значение) и вычитаем его из значения характеристики:

Получили матрицу координат векторов (МКВ) .

Следующим шагом как будто бы надо вычислить дисперсию для каждой характеристики и их нормировать. Но хотя таким образом мы действительно получим нормированные векторы, нам-то нужно, чтобы эти векторы были независимыми, то есть ортонормированными. Операция нормирования не поворачивает вектора (а лишь меняет их длину), а нам нужно развернуть векторы перпендикулярно друг другу. Как это сделать?

Правильный (но пока бесполезный) ответ — рассчитать собственные вектора и числа (спектр). Бесполезный потому, что мы не построили матрицу, для которой можно считать спектр. Наша матрица координат векторов (МКВ) не является квадратной — для нее собственные числа не рассчитаешь. Соответственно, надо на основе МКВ построить некую квадратную матрицу. Это можно сделать умножением МКВ на саму себя (возвести в квадрат).

Но тут — внимание! Неквадратную матрицу можно возвести в квадрат двумя способами — умножением исходной на транспонированную. И наоборот — умножением транспонированной на исходную. Размерность и смысл двух полученных матриц — разный.

Умножая МКВ на транспонированную, мы получаем матрицу корреляции:

Из данного определения (есть и другие) следует, что элементы матрицы корреляции являются скалярными произведениями векторов (грамиан на векторах). Значения главной диагонали отражают квадрат длины данных векторов. Значения матрицы не нормированы (обычно их нормируют, но для наших целей этого не нужно). Размерность матрицы корреляции совпадает с количеством исходных точек (векторов).

Теперь переставим перемножаемые в (8.1) матрицы местами и получим матрицу ковариации (опять же опускаем множитель 1/(1-n), которым обычно нормируют значения ковариации):

Здесь результат выражен в характеристиках. Соответственно, размерность матрицы ковариации равна количеству исходных характеристик (компонент). Для двух характеристик матрица ковариации имеет размерность 2×2, для трех — 3×3 и т.д.

Почему важна размерность матриц корреляции и ковариации? Фишка в том, что поскольку матрицы корреляции и ковариации происходят из произведения одного и того же набора векторов, то они имеют один и тот же набор собственных чисел, один и тот же ранг (количество независимых размерностей) матрицы. Как правило, количество векторов (точек) намного превышает количество компонент. Поэтому о ранге матриц судят по размерности матрицы ковариации.

Диагональные элементы ковариации отражают дисперсию компонент. Как мы видели выше, дисперсия и собственные числа тесно связаны. Поэтому можно сказать, что в первом приближении собственные числа матрицы ковариации (а значит, и корреляции) равны диагональным элементам (а если межкомпонентная дисперсия отсутствует, то равны в любом приближении).

Если стоит задача найти просто спектр матриц (собственные числа), то удобнее ее решать для матрицы ковариации, поскольку, как правило, их размерность небольшая. Но если нам необходимо найти еще и собственные вектора (определить собственную систему координат) для исходного набора, то необходимо работать с матрицей корреляции, поскольку именно она отражает скалярное произведение векторов.

Отметим, что метод главных компонент как раз и состоит в расчете спектра матрицы ковариации/корреляции для заданного набора векторных данных. Найденные компоненты спектра располагаются вдоль главных осей эллипсоида данных. Из нашего рассмотрения это вытекает потому, что главные оси — это и есть те оси, дисперсия (разброс) данных по которым максимален, а значит, и максимально значение спектра.

Правда, могут быть и отрицательные дисперсии, и тогда аналогия с эллипсоидом уже не очевидна.

9. Матрица Грина — это матрица корреляции векторов

Рассмотрим теперь ситуацию, когда нам известен не набор чисел, характеризующих точки (элементы), а набор расстояний между точками (причем между всеми). Достаточно ли данной информации для определения ССК (собственной системы координат) набора?

Ответ дан в первой части — да, вполне. Здесь же мы покажем, что построенная по формуле (1.3′) матрица Грина и определенная выше матрица корреляции векторов (8.1) — это одна и та же матрица.

Как такое получилось? Сами в шоке. Чтобы в этом убедиться, надо подставить выражение для элемента матрицы квадратов расстояний

в формулу преобразования девиации:

Отметим, что среднее значение матрицы квадратов расстояний отражает дисперсию исходного набора (при условии, что расстояния в наборе — это сумма квадратов компонент):

Подставляя (9.1) и (9.3) в (9.2), после несложных сокращений приходим к выражению для матрицы корреляции (8.1):

Итак, матрица Грина и матрица корреляции векторов — суть одно и то же. Ранг матрицы корреляции совпадает с рангом матрицы ковариации (количеством характеристик — размерностью пространства). Это обстоятельство позволяет строить спектр и собственную систему координат для исходных точек на основе матрицы расстояний.

Для произвольной матрицы расстояний потенциальный ранг (количество измерений) на единицу меньше количества исходных векторов. Расчет спектра (собственной системы координат) позволяет определить основные (главные) компоненты, влияющие на расстояния между точками (векторами).

Таким образом можно строить собственные координаты элементов либо на основании их характеристик, либо на основании расстояний между ними. Например, можно определить собственные координаты городов по матрице расстояний между ними.

Источник