- Индексация сайта

- Разбираемся в понятиях

- Как индексируют Яндекс и Google

- Как проверить?

- Как ускорить?

- Как закрыть страницы от роботов?

- На что влияет индексация?

- Резюме

- Индексация сайта в поисковых системах: что это такое и как ее ускорить

- Индексация сайта в поисковых системах: теория и определения

- Как правильно работать с сервисами, чтобы индексация сайта в поисковых системах проходила быстро

- Как сообщить поисковым роботам о новом сайте

- 1. Поместить ссылки на сайт на других ресурсах

- 2. Использовать профильные инструменты

- Дополнительный инструмент для добавления сайта в базу поисковых систем

- Проверка индексации сайта: как ее выполнить

- Как выполнить переобход страниц

- Переобход в Яндекс.Вебмастере

- Переобход в Search Console

- Индексация сайта в поисковых системах: как ускорить процесс

- 8 советов для оперативного индексирования сайта

- 1. Качественный контент

- 2. Скорость загрузки

- 3. Структура сайта

- 4. Перелинковка

- 5. Файл robots.txt

- 6. XML-карта сайта

- 7. Социальные сети

- 8. Проверка на ошибки

- Как закрыть сайт от индексации

- 1. Закрыть сайт от индексации через файл Robots.txt

- 2. Запретить индексацию сайта посредством мета-тегов

- Индексация сайта в поисковых системах: личный совет

Индексация сайта

Чтобы открыть онлайн-магазин, запустить информационный или развлекательный портал в сети необходим сайт – это, буквально, место или сегмент в виртуальном пространстве с уникальным адресом (домен), где размещается контент и файлы по проекту. Но чтобы ресурс можно было найти среди других, его необходимо «прописать» в специальной базе поисковых систем – индексе.

Что такое индексация сайта? Как её правильно выполнить и проверить? Можно ли ускорить этот процесс и полностью отказаться от него, на что влияет индекс? На все вопросы подробно отвечаем в этой статье.

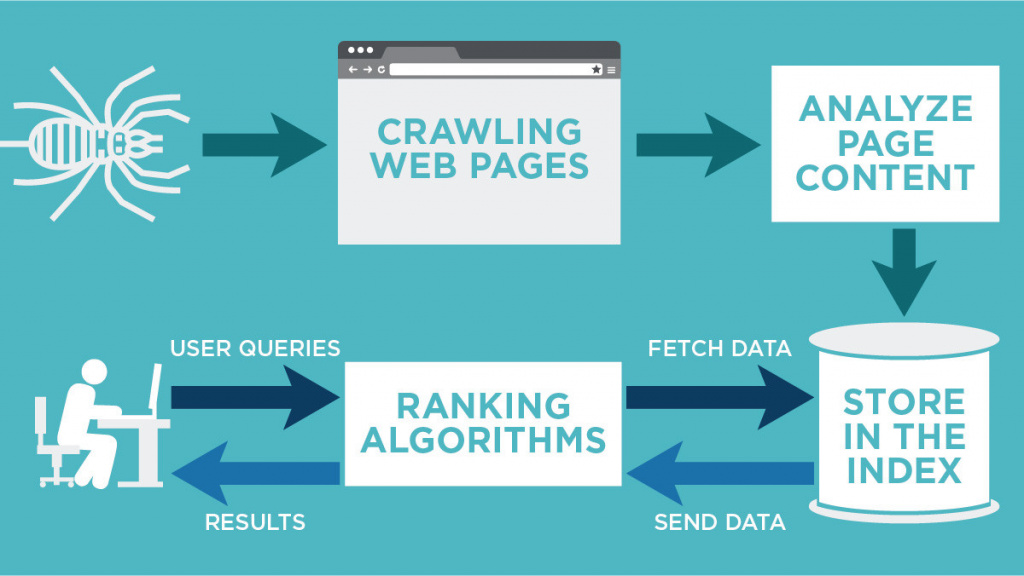

Разбираемся в понятиях

Индексация страницы – это процесс сбора, проверки и внесения информации о контенте сайта в базу поисковых систем. Такая непростая и трудоемкая работа поручается специальным роботам, которые целиком обходят весь сайт и, следуя установленным алгоритмам ПС, собирают информацию со страниц. При индексации учитываются внешние и внутренние ссылки, графические элементы, текстовое наполнение и другое. Если ресурс проходит проверку, то он вносится в индекс ПС, то есть пользователи смогут его найти по поисковым запросам.

Вся информация в базе – это выжимка данных, собранных поисковыми роботами с сайтов в Интернете. Пользователю, обратившемуся к такой библиотеке через ПС, предлагается сначала каталог сайтов с релевантной запросу информацией. Поисковые системы ранжируют ресурсы по собственным алгоритмам, учитывая полезность, тематику и другие параметры. Ознакомившись с краткой информацией о ресурсе (заголовок + сниппет), пользователь кликает на позицию в выдаче и переходит на целевую страницу для дальнейшего изучения.

Попытки структурировать сайты в сети были приняты в конце 90-х годов прошлого века. В то время алгоритмы ПС только разрабатывались, поэтому индекс напоминал предметный указатель по ключевым словам, которые находили роботы на проверяемых страницах. Соответственно в ТОП выдачи часто проникали переоптимизированные и абсолютно бесполезные для пользователей сайты. За 20-30 лет развития алгоритмы отбора усложнились. Сегодня роботы смотрят не только на попадание контента в тематику, но и на его качество, полезность для людей, доступность сайта с разных устройств, скорость загрузки и многое другое.

Как индексируют Яндекс и Google

Для большинства пользователей Рунета, индексация в поисковых системах – это добавление сайта в базу Яндекса и/или Гугла. Обычно достаточно прописать ресурсы только в этих поисковиках, чтобы развивать свой проект. Провести индексацию, независимо от выбранной ПС, можно двумя способами:

- Поисковые роботы самостоятельно находят и проверяют созданный сайт или его новые страницы. Многие эксперты считают такой вариант самым выгодным, ведь если ПС сами хотят внести ресурс в индекс, то он пользуется популярностью. Значит, приносит пользу. Как роботы определяют полезность страниц: наличие активных внешних ссылок, объемы трафика и вовлеченность посетителей. Если все условия выполняются, то индексация сайта проходит быстрее: от 24 часов до недели. В противном случае ПС могут и вовсе «забыть» о новом ресурсе. Работы у роботов хватает.

- Пользователь принудительно отправляет сайт на индексацию с помощью заполнения формы на сервисе поисковой системы. Созданные страницы помещаются в очередь на «прописку» и ждут посещения роботов ПС. Обычно добавляют URL главной страницы, а боты сами обходят весь ресурс, ориентируясь по карте сайта, меню и внутренним ссылкам. Используются сервисы Google Webmaster Tools и Яндекс.Вебмастер соответственно. Этот вариант занимает больше времени, но не требует финансовых затрат.

Для сканирования сайтов существуют разные боты ПС. Например, проверку новых страниц перед внесением в индекс делает основной робот, который проверяет весь контент на ресурсе. Новую информацию на проиндексированных страницах проверяет быстрый робот в соответствии с графиком обновления. Также используются боты для сканирования новостной ленты, графического контента и другие.

Как проверить?

Алгоритмы индексации и соответственно скорость работы ботов Яндекса и Гугла отличаются. Считается, что Google проверяет страницы быстрее. Это связано с тем, что система сначала сканирует сайт полностью – полезные и неполезные страницы, но в выдачу пропускает только качественные ресурсы. Таким образом, попадание в индекс Гугла ещё не гарантирует место в выдаче.

Индексация сайта в Яндексе, что это такое и почему долго? Роботы ПС проверяют только полезные материалы, отсеивая мусорные страницы. Поэтому индексация затягивается. В любом случае сканирование контента на соответствие требованиям выполняют обе системы: Яндекс сразу, а Гугл после «прописки».

Проверить индексацию можно тремя способами:

- Использовать инструменты вебмастеров, которые предоставляются поисковыми системами бесплатно – это webmaster.yandex.ru или google.com/webmasters. В Гугле откройте Search Console и далее раздел «Индекс Google». Информация о статусе сайта находится в блоке «Статус индексирования». В Яндексе пройдите по следующей цепочке: «Индексирование сайта» — «Страницы в поиске». Естественно нужно сначала внести в форму URL сайта и подтвердить права владельца.

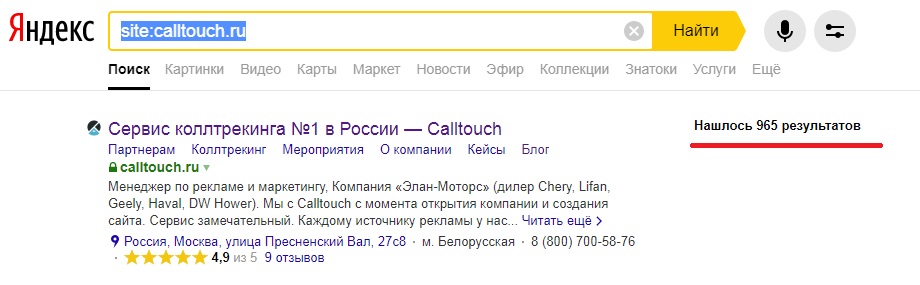

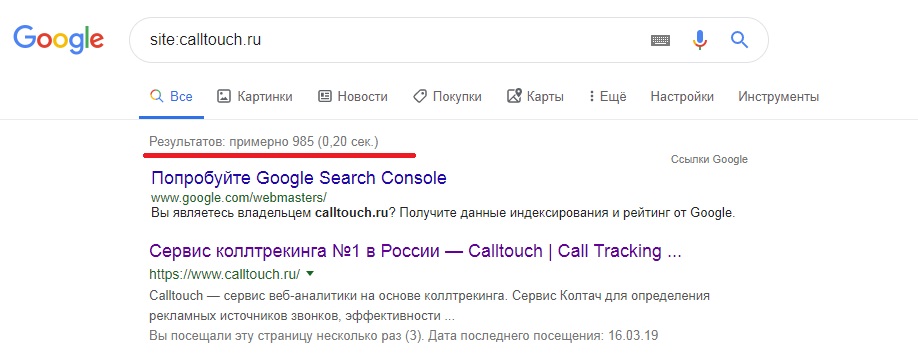

- Использовать специальные операторы, которые вводятся в поисковую строку. Для Яндекса и Гугла нужно прописать значение «site:» и после двоеточия добавить домен ресурса. Например: site:calltouch.ru. Таким способом можно узнать количество проиндексированных страниц. Если значения в Гугле и Яндексе сильно различаются, то вероятно сайт под фильтром.

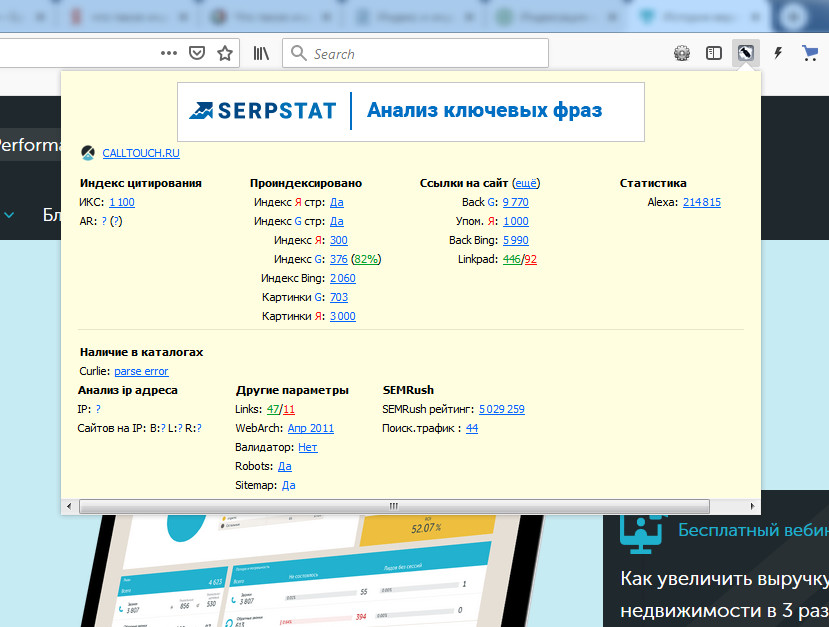

- Воспользоваться браузерными плагинами или спецсервисами. Это небольшие дополнения к веб-обозревателю, которые автоматически проверяют наличие страниц в индексе. Популярное решение — RDS Bar.

Как ускорить?

От того, как быстро роботы ПС проверят новый контент напрямую зависит скорость появления страниц в поисковой выдаче. Соответственно на сайт быстрее придет аудитория и совершит целевые действия. Скорость индексации зависит от нескольких факторов:

- Авторитетность сайта в сети, полезность для пользователей;

- Отсутствие ошибок при индексации;

- Качество и частота обновления контента;

- Наличие внутренних и внешних ссылок;

- Вложенность страниц;

- Правильно заполненные файлы sitemap.xml и robots.txt;

- Корректно выставленные ограничения в роботсе.

Для ускорения индексации рекомендуется выполнить следующие действия:

- Подобрать надежный и быстрый хостинг.

- Поставить сайт на индексацию в ПС Яндекса и Гугла.

- Корректно настроить robots.txt. В файле нужно запретить посещение технических, служебных страниц, просмотр другой информации, не представляющей пользы для посетителей.

- Создать файл карты sitemap.xml и сохранить его в корне сайта. По нему роботы проверяют структуру страниц, а также следят за обновлением контента.

- Проверить код главной и других страниц на наличие ошибок и дублей.

- Проверить текстовое наполнение на количество ключевых слов.

- Регулярно размещать на сайте новый полезный контент. Рекомендуется настроить внутреннюю перелинковку между статьями и страницами. Это простой и эффективный вариант повысить вовлеченность пользователей в проект и соответственно «подрасти» в выдаче.

- Настроить навигацию, сделать доступ к нужной странице с главного меню не длиннее 3-х кликов. К юзабилити сайтов сегодня предъявляются повышенные требования, так как это напрямую влияет на поведенческие факторы посетителей. Если до нужной информации расстояние в 10-12 кликов, то 90% пользователей покинут такой сайт.

- Разместить ссылки на ресурс в соцсетях, на тематических форумах, досках объявлений и других площадках генерации трафика.

Часто требуется уменьшить вес изображений, так как «тяжелая» графика замедляет загрузку страниц, плохо сказывается на индексировании и дальнейшем продвижении в поисковой выдаче.

Как закрыть страницы от роботов?

Выше мы узнали, что такое индексация страниц сайта, зачем она нужна, как ускорить этот процесс. Поговорим теперь, как спрятать от проверки информацию на страницах и зачем это делать. Обычно запрет на сканирование ботами ПС устанавливают, чтобы скрыть от публичного просмотра технические и служебные страницы, конфиденциальную информацию, ресурсы в разработке, дубли и другое.

То есть, чтобы качественно продвигаться в поиске, нужно знать, какие данные показывать, а какие скрывать.

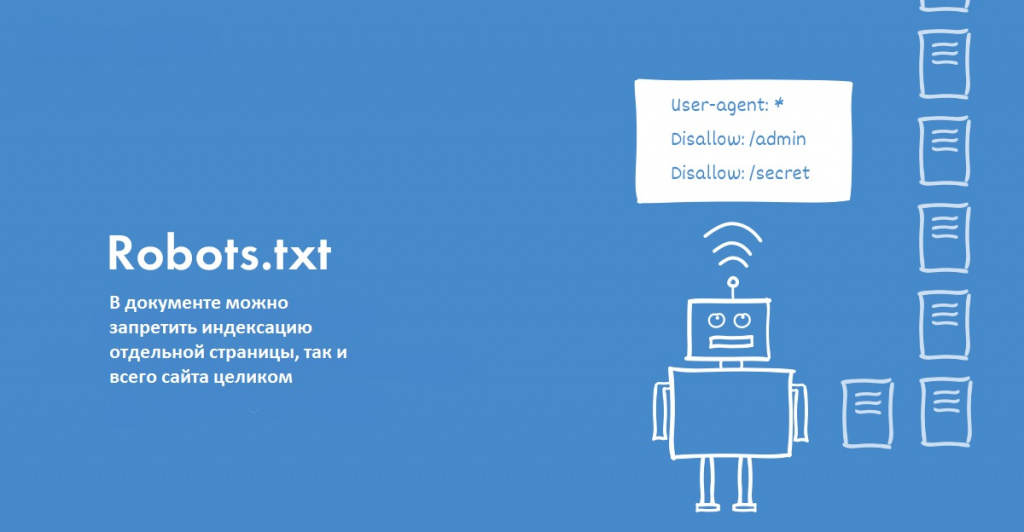

Поставить запрет на сканирование ботами можно несколькими способами:

- Использовать файл robots.txt. В документе можно запретить индексацию отдельной страницы, так и всего сайта целиком. Этот файл как раз и устанавливает правила для роботов ПС. Для запрета используются два основных оператора: указание адресата (User-agent) и запрещающая директива (Disallow), которая ставит «шлагбаум» для бота. Например, если сайт ещё не готов к запуску, то в роботсе можно прописать следующий код: User-agent: * и на следующей строке Disallow: /. Так вы закроете весь ресурс для роботов ПС.

- Прописать специальные теги в файле robots.txt. Обычно этот вариант используется для скрытия одной страницы от сканирования. Используются теги noindex и nofollow, которые запрещают ботам ПС проверять страницу или часть контента. Например, можно запретить работу конкретного бота следующим кодом: .

На что влияет индексация?

Благодаря «прописке» в поисковых системах Яндекса и Гугла, сайты попадают в поле видимости пользователей и потенциальных клиентов. Сама по себе целевая страница в сети, онлайн-магазин или Landing Page не представляет ценности. Полезность её определяют посетители. Соответственно находясь в индексе и регулярно обновляя контент, ресурс растет в выдаче. Это увеличивает приток трафика и помогает развивать проект.

Роботы ПС оценивают не только качество контента, но и поведенческие факторы, посещаемость, вовлеченность. С помощью этих метрик определяется полезность сайта. Чем лучше поведенческие факторы аудитории, тем выше страницы в ранге.

Первые 20 строк поисковой выдаче собирают 95% всего трафика по запросу. Поэтому быть в индексе на хорошем счету у ПС – это гарантия успешного продвижения и высоких конверсий.

Резюме

Мы рассмотрели, что такое индексация сайта в поисковых системах Яндекс и Гугла. Изучили основные моменты добавления, проверки и ускорения «прописки» в ПС. Узнали, как и зачем выставлять запреты на сканирование страниц ботами. У индексации простая задача, но с далеко идущими последствиями – внести информацию о сайте в базу поисковых систем.

Источник

Индексация сайта в поисковых системах: что это такое и как ее ускорить

Здравствуйте, друзья! Готовы получать новые знания? Сегодня я расскажу вам, что такое индексация сайта в поисковых системах, как она проводится и как ее ускорить. Эти знания будут полезны всем, кто занимается ведением своего интернет-проекта, но не представляет, как повысить его показатели поисковой выдачи. Прочитав мою статью, вы получите много ценных и полезных знаний, применив которые на практике, сможете обеспечить активный рост позиций проекта.

После прочтения статьи, вы будете знать, как существенным образом улучшить, активизировать индексацию ресурса. Применив мои рекомендации на практике, добьетесь лояльного отношения к сайту поисковых роботов. Отдельно – хотя и лаконично – расскажу о том, какие требования предъявляют поисковые ресурсы к сайтам и как их правильно соблюдать.

Прочитав статью, вы узнаете:

- определение индексации;

- особенности взаимодействия с поисковыми роботами;

- как проверять индексацию;

- что такое страница переобхода и как с ней работать;

- как активизировать индексацию;

- и многое другое.

Информация – теоретическая, хотя и с конкретными примерами, картинками, рисунками.

Кстати! Для поклонников практического варианта обучения рекомендую записаться на мой авторский тренинг, как сделать сайт своими руками. Он длится всего 4 дня. После его завершения у вас будет свой рабочий проект, с первыми статьями. Во время обучения я также на практических примерах показываю, как заниматься продвижением сайта самостоятельно.

Итак, если вам интересна информация, что такое индексация сайта в поисковых системах, возьмите чашку чая или кофе и отправляйтесь в приятное путешествие по волнам знаний.

Индексация сайта в поисковых системах: теория и определения

Чтобы вам было понятно, что представляет собой индексация сайта в поисковых системах, приведу простой пример. Предположим, что интернет-ресурс – это набор документов, каждый из которых несет в себе определенную информацию.

Поисковые системы – это своеобразные информационные каталоги, которые функционирует по конкретным установленным правилам и параметрам. Посредством них пользователи находят нужную им информацию – иногда на это нужно относительно много времени, а иногда достаточно буквально пары минут.

Чтобы предоставить пользователям корректные результаты поиска, поисковая система должна:

- тщательно проверить каждый отдельный документ;

- убедиться, какая именно информация в нем содержится;

- а потом разместить в определенной последовательности относительно прочих подобных документов – в нашем случае подразумеваются страницы сайтов.

Важно! Процесс индексации представляет собой добавление информации о существующем сайте в базу данных поисковых систем.

Для проведения индексации поисковые роботы:

- сканируют все содержимое на сайте;

- определяют его особенности;

- передают данные о содержимом в базы поисковых систем;

- и уже после этого сервисы поиска ранжируют страницы относительно друг друга в зависимости от качества и особенностей предоставляемой информации.

После завершения ранжирования все материалы отправляются в поисковую выдачу. Позиция в выдаче зависит от ряда факторов, среди которых есть несколько наиболее важных:

- качество и ценность публикуемых на сайте материалов (текстовых, визуальных);

- общее качество всего сайта в целом;

- уровень технической оптимизации;

- уровень поисковой (внешней) оптимизации.

Все поисковые сервисы выстроены таким образом, дабы пользователи могли получать наиболее качественную информацию.

Обратите внимание! Именно по этой причине разработчики, технический персонал, работающий в поисковых гигантах, постоянно трудится над совершенствованием выдачи, алгоритмов. Системы постоянно совершенствуются и видоизменяются.

Ранее специалисты в вопросах оптимизации и продвижения сайтов, вебмастера ставили перед собой единственную цель – задобрить именно поисковых роботов, сканирующих страницы их проекта. То есть, они подстраивались под все требования роботов, дабы сайт максимально точно соответствовал предпочтениям машин.

Сегодня такой подход уже не позволяет достичь нужного результата. Роботы становятся умнее, они без труда отличают простой «сеошный» контент, не несущий никакой пользы для посетителей, от действительно ценного и качественного наполнения.

Поэтому, чтобы индексация сайта в поисковых системах проходила эффективно, необходимо максимально повысить поведенческие факторы. То есть, чтобы пользователи:

- проводили на сайте много времени;

- переходили по страницам;

- читали статьи;

- делились материалами в социальных сетях;

- писали комментарии и т.д.

Добиться таких результатов возможно лишь в том случае, если создавать проекты непосредственно для людей, читателей.

Если статьи слишком переоптимизированны (то есть, в них слишком большое количество поисковых запросов), контент – низкокачественный и не ориентированный на людей, рассчитывать на высокие позиции в выдаче не приходится. В худшем случае – можно даже попасть под санкции, фильтры поисковых систем. В результате чего страницы получат низкий приоритет выдачи. А иногда – даже полный запрет индексации: материалы, страницы сайта будут просто удалены из поисковых баз и пользователи не смогут найти их через поисковые сервисы.

Обратите внимание! Избавиться от фильтров и санкций реально – нейтрализовать все недочеты, исправить ошибки, переделать контент. Однако на это нужно много времени и финансов. Поэтому лучше сразу их не допускать, дабы не было проблем в будущем. В некоторых случаях придется даже писать запросы в службу технической поддержки поисковых сервисов, дабы была проведена повторная проверка ресурса.

Следует помнить и о том, что у каждой поисковой системы есть свои правила и нормы. Во многом они перекликаются, поэтому оптимизация под одну систему подразумевает оптимизацию и под другую. Однако есть и уникальные особенности. Так что добиться корректной выдачи иногда не так просто, как может показаться на первый взгляд.

Как правильно работать с сервисами, чтобы индексация сайта в поисковых системах проходила быстро

Основными поисковыми системами, используемыми в нашей части планеты, являются Google и Yandex. Именно через них люди ищут необходимую информацию, статьи, сайты. Поэтому и оптимизировать ресурсы нужно под требования данных поисковых сервисов.

Как сообщить поисковым роботам о новом сайте

Когда запускается новый сайт, логично, что поисковые системы и роботы о нем ничего не знают. Поэтому, дабы ваш проект был включен в выдачу, необходимо передать сервисам эту информацию. Сделать «передачу» можно двумя способами.

1. Поместить ссылки на сайт на других ресурсах

Наличие таких ссылок как будто дает команду поисковым роботам: «Внимание! Смотрите! Появился новый полезный и интересный для людей проект». Они переходят по ссылкам и индексируют страницы ресурса, анализируют их и собирают нужную для ранжирования информацию.

2. Использовать профильные инструменты

Чтобы проводилась индексация сайта в поисковых системах, также можно использовать специализированные сервисы для вебмастеров, имеющиеся в поисковых системах. Они также позволяют получать важную информацию о вашем сайте:

- статистику посещений;

- количество посетителей;

- число показов;

- число кликов;

- удаленные страницы;

- добавленные страницы;

- и многое другое.

Анализ этой информации позволяет вносить изменения в сайт, делать его более полезным, ценным, проводить внутреннюю и внешнюю оптимизацию.

Добавив свой проект в указанные сервисы, вы также даете команду поисковым роботам провести индексацию страниц. Если на страницах сайта нет команды, способной закрыть сайт от индексации (такие запреты обычно прописываются в файле Robots.txt или через специальные мета-теги), роботы просканируют проект, соберут информацию и добавят его в поисковую базу для последующей выдачи.

Обратите внимание! Сроки индексации для только что созданных сайтов определяются индивидуально. Иногда на это уходит всего несколько дней, а иногда – необходимо даже несколько недель. Хотя в целом сегодня поисковые роботы выполняют все действия оперативно, при условии, что ресурс добавлен в соответствующие сервисы поисковых гигантов, коими являются Яндекс.Вебмастер (от Yandex)и Search Console (от Google).

Не стоит думать, что добавление сайта в поисковую базу – это обязательный доступ к статьям по тем или иным поисковым запросам. Для этого – чтобы статью можно было найти посредством «ключей» — необходимо определенное время. Иногда – даже слишком продолжительное. Все зависит от нескольких факторов. Однако рано или поздно поисковые роботы таки проведут оценку содержимого сайта и добавят его страницы в выдачу.

Кстати! Некоторые владельцы проектов предварительно наполняют сайт большим количеством материалов, а только потом открывают его для индексации. При таком варианте на проведение анализа необходимо значительно больше времени. Поскольку роботам придется иметь дело с большими объемами информации.

Если вас интересуют конкретные сроки, то после отправки сообщения о странице, сайте и до появления в выдаче нужно от 7 до 15 дней.

Дополнительный инструмент для добавления сайта в базу поисковых систем

Кроме двух методов, представленных выше, есть еще один способ, как добавить сайт в базу поисковых систем. Хотя его эффективность чуть ниже. Суть его заключается в введение в поисковую строку специальной команды:

- для Google — Site: Название + project.com;

- для Яндекс — Host: Название + project.com, где project.com – домен вашего проекта.

Кстати! Существуют также специализированные сервисы, позволяющие выполнить такое добавление. Они автоматизированы. Честно – какой результат их использования, точно сказать не могу. Потому что пользуюсь проверенными методами. Но могу предложить, что сервисы выполняют перечисленные выше команды либо же занимаются размещением ссылок на внешних источниках.

Проверка индексации сайта: как ее выполнить

Теперь про еще один важный момент. Обязательно нужно проверять, как проводится индексация ресурса. Необходимо убедиться, что все страницы проекта восприняты роботами правильно, адекватно.

Как выполняется проверка индексации сайта? Все зависит от того, как именно вы его добавляли. Например, если через «официальные» инструменты в панели вебмастеров поисковых сервисов – все просто. Статус представлен в отдельном разделе. Там указывается вся нужная и актуальная информация:

- какой статус страницы;

- когда ее роботы посещали последний раз;

- и многое другое.

Еще один метод – использовать поисковую строку. Суть – в том, дабы использовать специальных операторов, информация о которых представлена в официальной документации для поисковых систем.

Также можно использовать отдельные сервисы, разработанные для этих целей. Ими нужно пользоваться в случаях, если необходима полномасштабная проверка множества страниц. Такие сервисы существенно упрощают жизнь вебмастерам и SEO-оптимизаторам. Среди них можно выделить два:

Они простые для понимания. Есть инструкции по работе с ними. Поэтому отдельно расписывать их не буду.

Как выполнить переобход страниц

В некоторых случаях правильным будет «пригласить» робота на повторный обход страницы. Для этого есть специальные инструменты, опции в панели для вебмастеров.

Переобход в Яндекс.Вебмастере

Для этого нужно в панели инструментов:

- кликнуть по вкладке Индексирование;

- в ней выбрать раздел Переобход страниц;

- ввести адреса страниц, для которых необходим переобход;

- адреса вводятся в столбик – одна строка для одной ссылки;

- кликнуть кнопку «Отправить».

После этого в ближайшие часы поисковые роботы от системы Яндекса придут к вашим страницам, чтобы снова изучить и проанализировать их, присвоить другой статус.

Переобход в Search Console

Не возникнет проблем с данной задачей и в консоли Google. Для этого необходимо:

- скопировать нужный адрес;

- вставить его в специальное поле, которое находится в верхней части панели инструментов;

- после чего кликнуть по кнопке с соответствующей надписью – на ней написано «Запросить индексацию».

Индексация сайта в поисковых системах: как ускорить процесс

Индексация сайта в поисковых системах может проводиться и быстрее. Но только в том случае, если соблюдать все предусмотренные требования. Главное из них – как именно вы решили добавить проект в поисковую систему: оптимальный вариант подразумевает использование панели инструментов вебмастеров. После чего там будут появляться рекомендации – следует обязательно читать их и выполнять. Таким образом, скорость индексации страниц существенно вырастет.

8 советов для оперативного индексирования сайта

1. Качественный контент

Уделите особое внимание качеству материалов, которые вы готовите для своего сайта. Чем более интересными, полезными для читателей они будут, тем более высока вероятность быстрой индексации – на нее будет уходить всего лишь несколько часов, а не суток.

2. Скорость загрузки

Необходимо оптимизировать сайт и материалы так, чтобы скорость загрузки страниц была максимально быстрой. Для этого необходимо уменьшить вес картинок, проработать HTML, CSS, JS. Также на скорость загрузки страницы оказывает непосредственное воздействие хостинг. Уделите повышенное внимание его подбору – чем он качественнее, тем лучше работает сайт в целом.

3. Структура сайта

Также нужно проработать структуру сайта, дабы она была правильной, понятной для пользователей, удобной и простой для навигации по страницам проекта.

4. Перелинковка

Необходимо обязательно делать внутреннюю перелинковку. Это необходимо по одной простой причине – когда робот индексирует страницу, он также обязательно прорабатывает «документы», на которые стоят ссылки.

5. Файл robots.txt

Этот файл являет собой своеобразную инструкцию для поисковых роботов. В ней нужно прописать, какие страницы не нужно анализировать и добавлять в поисковую выдачу. Так вы избавите её от всяких ненужных разделов. Это полезно для проекта в целом. Ведь «машины» будут чаще приходить на проект, если увидят, что на нем нет «мусорных» для пользователей разделов.

6. XML-карта сайта

Необходимо обязательно создать ее и добавить в панели для вебмастеров. Посредством такой карты роботы лучше ориентируются в представленных на ресурсе материалах. Что способствует более оперативной индексации.

7. Социальные сети

Обязательно используйте их силу. Создайте во всех возможных сетях профили проекта – официальные страницы со ссылкой на сайт в целом в описании сообщества. Регулярно публикуйте в социальных сетях ссылки на свои новые материалы. Это очень полезно для продвижения сайта.

8. Проверка на ошибки

Также следует постоянно проводить проверку сайта на ошибки. Если они имеются, обязательно устранять их. Самые критические, опасные отображаются в консоли вебмастеров. Кроме того, имеются особые валидаторы, которые помогают выявить недочеты в коде сайта.

Как закрыть сайт от индексации

В некоторых случаях необходимо запретить индексацию сайта. Например, если вы хотите сначала наполнить его материалами, а только потом открывать его для роботов. Или же на проекте имеются определенные ошибки, недочеты и вы хотите исправить их, а только потом допускать к нему «машины», чтобы исключить санкции и фильтры.

Существуют два проверенных метода, позволяющих закрыть сайт от индексации. Расскажу о каждом из них.

1. Закрыть сайт от индексации через файл Robots.txt

Тут все просто. Полностью удаляете все, что содержится в файле, заменяя его следующей информацией:

Тем самым, поисковые роботы понимают, что ваш проект в целом не нуждается в индексации. Ни одна из его страница не требует посещения и анализа.

Отдельно можно запретить доступ к страницам роботам конкретной поисковой сети. Сделать это просто. Вместо звездочки в строке User-agent нужно вписать название системы:

- Googlebot для Гугл;

- Yandex для Яндекса;

- и так далее.

Когда запрет нужно будет снять, снова удаляете все содержимое и вставляет нормальный набор команд.

2. Запретить индексацию сайта посредством мета-тегов

Тут все несколько не то, чтобы сложнее, но имеет определенные особенности. Суть метода состоит в том, чтобы на каждой страницы, которая не должна допускать к себе роботов, нужно прописать специальные теги:

Если необходимо закрыть доступ определенным поисковым системам, мета-теги будут выглядеть следующим образом:

Обратите внимание! Если сайт сделан на платформе WordPress, поможет в размещении тегов специальное расширение Yoast SEO. В нем предусмотрены особые опции, которые и отвечают за эти действия. С помощью тегов можно закрывать, как отдельные страницы, так и весь сайт в целом.

Считается, что правильнее закрывать сайт в целом посредством Robots.txt, а с помощью тегов отдельные страницы.

Индексация сайта в поисковых системах: личный совет

Теперь вы знаете, что нужно делать для того, чтобы индексация сайта в поисковых системах проходила максимально быстро и эффективно. Ничего сложного в выполнении таких действий нет. Достаточно:

- добавить его в консоли для вебмастеров;

- проверять на наличие ошибок и исправлять их;

- регулярно добавлять качественные материалы;

- не нарушать установленные правила.

Уже этого достаточно, чтобы добиться позитивной оценки со стороны поисковых роботов. Что положительно отразится на сроках индексации и позициях в выдаче.

Конечно, если вы новичок в этом направлении, разобраться вам будет несколько сложновато. Однако тщательно разобравшись в теме, вы быстро освоитесь и добьетесь успеха.

Если вам нужны практические советы, рекомендации, вы хотите узнать больше информации о разработке и продвижении сайтов, приглашаю на мой авторский бесплатный тренинг, который длится всего 4 дня. И в режиме онлайн. Повторяя за мной, вы своими руками сделаете качественный сайт, с первыми статьями, готовый для последующего продвижения.

Источник