- Энтропия? Это просто!

- Так что же такое энтропия?

- Физический пример: газ под поршнем

- Твёрдые тела и потенциальная энергия

- Понимаем второй закон термодинамики

- Перемешивание газов

- Разбираемся с демоном Максвелла

- Энтропия. Физический смысл энтропии. Энтропия и вероятность

- Энтропия. Физический смысл энтропии. Энтропия и вероятность

Энтропия? Это просто!

Этот пост является вольным переводом ответа, который Mark Eichenlaub дал на вопрос What’s an intuitive way to understand entropy?, заданный на сайте Quora

Энтропия. Пожалуй, это одно из самых сложных для понимания понятий, с которым вы можете встретиться в курсе физики, по крайней мере если говорить о физике классической. Мало кто из выпускников физических факультетов может объяснить, что это такое. Большинство проблем с пониманием энтропии, однако, можно снять, если понять одну вещь. Энтропия качественно отличается от других термодинамических величин: таких как давление, объём или внутренняя энергия, потому что является свойством не системы, а того, как мы эту систему рассматриваем. К сожалению в курсе термодинамики её обычно рассматривают наравне с другими термодинамическими функциями, что усугубляет непонимание.

Так что же такое энтропия?

Энтропия — это то, как много информации вам не известно о системе

Например, если вы спросите меня, где я живу, и я отвечу: в России, то моя энтропия для вас будет высока, всё-таки Россия большая страна. Если же я назову вам свой почтовый индекс: 603081, то моя энтропия для вас понизится, поскольку вы получите больше информации.

Почтовый индекс содержит шесть цифр, то есть я дал вам шесть символов информации. Энтропия вашего знания обо мне понизилась приблизительно на 6 символов. (На самом деле, не совсем, потому что некоторые индексы отвечают большему количеству адресов, а некоторые — меньшему, но мы этим пренебрежём).

Или рассмотрим другой пример. Пусть у меня есть десять игральных костей (шестигранных), и выбросив их, я вам сообщаю, что их сумма равна 30. Зная только это, вы не можете сказать, какие конкретно цифры на каждой из костей — вам не хватает информации. Эти конкретные цифры на костях в статистической физике называют микросостояниями, а общую сумму (30 в нашем случае) — макросостоянием. Существует 2 930 455 микросостояний, которые отвечают сумме равной 30. Так что энтропия этого макросостояния равна приблизительно 6,5 символам (половинка появляется из-за того, что при нумерации микросостояний по порядку в седьмом разряде вам доступны не все цифры, а только 0, 1 и 2).

А что если бы я вам сказал, что сумма равна 59? Для этого макросостояния существует всего 10 возможных микросостояний, так что его энтропия равна всего лишь одному символу. Как видите, разные макросостояния имеют разные энтропии.

Пусть теперь я вам скажу, что сумма первых пяти костей 13, а сумма остальных пяти — 17, так что общая сумма снова 30. У вас, однако, в этом случае имеется больше информации, поэтому энтропия системы для вас должна упасть. И, действительно, 13 на пяти костях можно получить 420-ю разными способами, а 17 — 780-ю, то есть полное число микросостояний составит всего лишь 420х780 = 327 600. Энтропия такой системы приблизительно на один символ меньше, чем в первом примере.

Мы измеряем энтропию как количество символов, необходимых для записи числа микросостояний. Математически это количество определяется как логарифм, поэтому обозначив энтропию символом S, а число микросостояний символом Ω, мы можем записать:

Это есть ничто иное как формула Больцмана (с точностью до множителя k, который зависит от выбранных единиц измерения) для энтропии. Если макросостоянию отвечают одно микросостояние, его энтропия по этой формуле равна нулю. Если у вас есть две системы, то полная энтропия равна сумме энтропий каждой из этих систем, потому что log(AB) = log A + log B.

Из приведённого выше описания становится понятно, почему не следует думать об энтропии как о собственном свойстве системы. У системы есть опеделённые внутренняя энергия, импульс, заряд, но у неё нет определённой энтропии: энтропия десяти костей зависит от того, известна вам только их полная сумма, или также и частные суммы пятёрок костей.

Другими словами, энтропия — это то, как мы описываем систему. И это делает её сильно отличной от других величин, с которыми принято работать в физике.

Физический пример: газ под поршнем

Классической системой, которую рассматривают в физике, является газ, находящийся в сосуде под поршнем. Микросостояние газа — это положение и импульс (скорость) каждой его молекулы. Это эквивалентно тому, что вы знаете значение, выпавшее на каждой кости в рассмотренном раньше примере. Макросостояние газа описывается такими величинами как давление, плотность, объём, химический состав. Это как сумма значений, выпавших на костях.

Величины, описывающие макросостояние, могут быть связаны друг с другом через так называемое «уравнение состояния». Именно наличие этой связи позволяет, не зная микросостояний, предсказывать, что будет с нашей системой, если начать её нагревать или перемещать поршень. Для идеального газа уравнение состояния имеет простой вид:

хотя вы, скорее всего, лучше знакомы с уравнением Клапейрона — Менделеева pV = νRT — это то же самое уравнение, только с добавлением пары констант, чтобы вас запутать. Чем больше микросостояний отвечают данному макросостоянию, то есть чем больше частиц входят в состав нашей системы, тем лучше уравнение состояния её описывают. Для газа характерные значения числа частиц равны числу Авогадро, то есть составляют порядка 10 23 .

Величины типа давления, температуры и плотности называются усреднёнными, поскольку являются усреднённым проявлением постоянно сменяющих друг друга микросостояний, отвечающих данному макросостоянию (или, вернее, близким к нему макросостояниям). Чтобы узнать в каком микросостоянии находится система, нам надо очень много информации — мы должны знать положение и скорость каждой частицы. Количество этой информации и называется энтропией.

Как меняется энтропия с изменением макросостояния? Это легко понять. Например, если мы немного нагреем газ, то скорость его частиц возрастёт, следовательно, возрастёт и степень нашего незнания об этой скорости, то есть энтропия вырастет. Или, если мы увеличим объём газа, отведя поршень, увеличится степень нашего незнания положения частиц, и энтропия также вырастет.

Твёрдые тела и потенциальная энергия

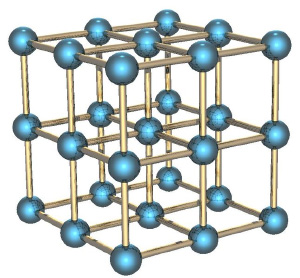

Если мы рассмотрим вместо газа какое-нибудь твёрдое тело, особенно с упорядоченной структурой, как в кристаллах, например, кусок металла, то его энтропия будет невелика. Почему? Потому что зная положение одного атома в такой структуре, вы знаете и положение всех остальных (они же выстроены в правильную кристаллическую структуру), скорости же атомов невелики, потому что они не могут улететь далеко от своего положения и лишь немного колеблются вокруг положения равновесия.

Если кусок металла находится в поле тяготения (например, поднят над поверхностью Земли), то потенциальная энергия каждого атома в металле приблизительно равна потенциальной энергии других атомов, и связанная с этой энергией энтропия низка. Это отличает потенциальную энергию от кинетической, которая для теплового движения может сильно меняться от атома к атому.

Если кусок металла, поднятый на некоторую высоту, отпустить, то его потенциальная энергия будет переходить в кинетическую энергию, но энтропия возрастать практически не будет, потому что все атомы будут двигаться приблизительно одинаково. Но когда кусок упадёт на землю, во время удара атомы металла получат случайное направление движения, и энтропия резко увеличится. Кинетическая энергия направленного движения перейдёт в кинетическую энергию теплового движения. Перед ударом мы приблизительно знали, как движется каждый атом, теперь мы эту информацию потеряли.

Понимаем второй закон термодинамики

Второй закон термодинамики утверждает, что энтропия (замкнутой системы) никогда не уменьшается. Мы теперь можем понять, почему: потому что невозможно внезапно получить больше информации о микросостояниях. Как только вы потеряли некую информацию о микросостоянии (как во время удара куска металла об землю), вы не можете вернуть её назад.

Давайте вернёмся обратно к игральным костям. Вспомним, что макросостояние с суммой 59 имеет очень низкую энтропию, но и получить его не так-то просто. Если бросать кости раз за разом, то будут выпадать те суммы (макросостояния), которым отвечает большее количество микросостояний, то есть будут реализовываться макросостояния с большой энтропией. Самой большой энтропией обладает сумма 35, и именно она и будет выпадать чаще других. Именно об этом и говорит второй закон термодинамики. Любое случайное (неконтролируемое) взаимодействие приводит к росту энтропии, по крайней мере до тех пор, пока она не достигнет своего максимума.

Перемешивание газов

И ещё один пример, чтобы закрепить сказанное. Пусть у нас имеется контейнер, в котором находятся два газа, разделённых расположенной посередине контейнера перегородкой. Назовём молекулы одного газа синими, а другого — красными.

Если открыть перегородку, газы начнут перемешиваться, потому что число микросостояний, в которых газы перемешаны, намного больше, чем микросостояний, в которых они разделены, и все микросостояния, естественно, равновероятны. Когда мы открыли перегородку, для каждой молекулы мы потеряли информацию о том, с какой стороны перегородки она теперь находится. Если молекул было N, то утеряно N бит информации (биты и символы, в данном контексте, это, фактически, одно и тоже, и отличаются только неким постоянным множителем).

Разбираемся с демоном Максвелла

Ну и напоследок рассмотрим решение в рамках нашей парадигмы знаменитого парадокса демона Максвелла. Напомню, что он заключается в следующем. Пусть у нас есть перемешанные газы из синих и красных молекул. Поставим обратно перегородку, проделав в ней небольшое отверстие, в которое посадим воображаемого демона. Его задача — пропускать слева направо только красных, и справа налево только синих. Очевидно, что через некоторое время газы снова будут разделены: все синие молекулы окажутся слева от перегородки, а все красные — справа.

Получается, что наш демон понизил энтропию системы. С демоном ничего не случилось, то есть его энтропия не изменилась, а система у нас была закрытой. Получается, что мы нашли пример, когда второй закон термодинамики не выполняется! Как такое оказалось возможно?

Решается этот парадокс, однако, очень просто. Ведь энтропия — это свойство не системы, а нашего знания об этой системе. Мы с вами знаем о системе мало, поэтому нам и кажется, что её энтропия уменьшается. Но наш демон знает о системе очень много — чтобы разделять молекулы, он должен знать положение и скорость каждой из них (по крайней мере на подлёте к нему). Если он знает о молекулах всё, то с его точки зрения энтропия системы, фактически, равна нулю — у него просто нет недостающей информации о ней. В этом случае энтропия системы как была равна нулю, так и осталась равной нулю, и второй закон термодинамики нигде не нарушился.

Но даже если демон не знает всей информации о микросостоянии системы, ему, как минимум, надо знать цвет подлетающей к нему молекулы, чтобы понять, пропускать её или нет. И если общее число молекул равно N, то демон должен обладать N бит информации о системе — но именно столько информации мы и потеряли, когда открыли перегородку. То есть количество потерянной информации в точности равно количеству информации, которую необходимо получить о системе, чтобы вернуть её в исходное состояние — и это звучит вполне логично, и опять же не противоречит второму закону термодинамики.

Источник

Энтропия. Физический смысл энтропии. Энтропия и вероятность

Энтропия. Физический смысл энтропии. Энтропия при обратимых и необратимых процессах в замкнутой системе. Второе начало термодинамики и превращение теплоты в работу.

Энтропия. Физический смысл энтропии. Энтропия и вероятность

Рассматривая КПД тепловой машины, работающей по циклу Карно,

Используя первое начало термодинамики для обратимых процессов,

Выразим из уравнения Менделеева-Клапейрона

Учтём, что

Правая часть этого равенства является полным дифференциалом, следовательно, при обратимых процессах и приведённая теплота тоже является полным дифференциалом, что является признаком функции состояния.

Функция состояния, дифференциалом которой является

где dS – приращение энтропии. Равенство (3.73) справедливо только для обратимых процессов и удобно для расчёта изменения энтропии при конечных процессах:

Если система обратимым путём совершает круговой процесс (цикл), то

Выражая количество теплоты через приращение энтропии для элементарного процесса, и подставляя его в уравнение для первого начала термодинамики, получим новый вид записи этого уравнения, которое принято называть основным термодинамическим тождеством 3:

Таким образом, для расчёта изменения энтропии при обратимых процессах удобно использовать приведённую теплоту.

В случае необратимых неравновесных процессов

Рассмотрим, что происходит с энтропией в изолированной термодинамической системе. В изолированной термодинамической системе при любом обратимом изменении состояния её энтропия не изменится. Математически это можно записать так: ?S = 0 или S = const.

Рассмотрим, что происходит с энтропией термодинамической системы при необратимом процессе. Предположим, что переход из состояния 1 в состояние 2 по пути L1 обратим, а из состояния 2 в состояние 1 по пути L2 – необратим (рис.3.13).

Тогда справедливо неравенство Клаузиуса (3.76). Запишем выражение для правой части этого неравенства, соответствующее нашему примеру:

Первое слагаемое в этой формуле может быть заменено изменением энтропии, так как этот процесс обратимый. Тогда неравенство Клаузиуса можно записать в виде:

Отсюда

Если система изолирована, то

то есть энтропия изолированной системы при необратимом процессе возрастает. Рост энтропии продолжается не беспредельно, а до определённого максимального значения, характерного для данного состояния системы. Это максимальное значение энтропии соответствует состоянию термодинамического равновесия. Рост энтропии при необратимых процессах в изолированной системе означает, что энергия, которой обладает система, становится менее доступной для преобразования в механическую работу. В состоянии равновесия, когда энтропия достигает максимального значения, энергия системы не может быть преобразована в механическую работу.

Если же система не изолирована, то энтропия может, как убывать, так и возрастать в зависимости от направления теплообмена.

Энтропия как функция состояния системы, может служить таким же параметром состояния, как температура, давление, объём. Изображая тот или иной процесс на диаграмме (Т,S), можно дать математическую интерпретацию количества теплоты, как площади фигуры под кривой, изображающей процесс. На рис. 3.14 приведена диаграмма для изотермического процесса в координатах энтропия – температура.

Энтропия может быть выражена через параметры состояния газа – температуру, давление, объём. Для этого из основного термодинамического тождества (3.75) выразим приращение энтропии:

Проинтегрируем это выражение и получим:

Изменение энтропии можно выразить и через другую пару параметров состояния – давление и объём. Для этого нужно выразить температуры начального и конечного состояний из уравнения состояния идеального газа через давление и объём и подставить в (3.79):

При изотермическом расширении газа в пустоту Т1 = Т2, а значит первое слагаемое в формуле (3.79) обнулится и изменение энтропии будет определяться только вторым слагаемым:

Несмотря на то, что во многих случаях для расчёта изменения энтропии удобно использовать приведённую теплоту, ясно, что приведённая теплота и энтропия – разные, не тождественные понятия.

Рассмотрим физический смысл энтропии. Для этого используем формулу (3.81), для изотермического процесса, при котором не изменяется внутренняя энергия, а всевозможные изменения характеристик обусловлены лишь изменением объёма. Рассмотрим связь объёма, занимаемого газом в равновесном состоянии, с числом пространственных микросостояний частиц газа. Число микросостояний частиц газа, с помощью которых реализуется данное макросостояние газа как термодинамической системы, можно подсчитать следующим образом. Разобьём весь объём на элементарные кубические ячейки со стороной d

10 –10 м (порядка величины эффективного диаметра молекулы). Объём такой ячейки будет равен d 3 . В первом состоянии газ занимает объём V1, следовательно, число элементарных ячеек, то есть число мест N1, которые могут занимать молекулы в этом состоянии будет равно

Число микросостояний системы, занимающей объём V1, обозначим через Г1 и определим, подсчитав число размещений NA (число Авогадро) молекул, которые содержатся в 1 моле газа, по N1 ячейкам (местам):

Число микросостояний Гi, с помощью которых можно реализовать i- тое макросостояние, называется термодинамической вероятностью данного макросостояния. Термодинамическая вероятность Г ≥ 1.

Для идеальных газов число свободных мест гораздо больше числа молекул, то есть N1 >> NA и N2 >> NA.. Тогда, учитывая выражение чисел N1 и N2 через соответствующие объёмы, получим:

Отсюда можно выразить отношение объёмов через отношение термодинамических вероятностей соответствующих состояний:

Подставим (3.83) в (3.82) и получим:

Формула (3.84) называется формулой Больцмана, впервые получившего её и понявшего статистический смысл энтропии, как функции беспорядка. Формула Больцмана имеет более общее значение, чем формула (3.82), то есть может быть использована не только для идеальных газов, и позволяет раскрыть физический смысл энтропии. Чем более упорядочена система, тем меньше число микросостояний, посредством которых осуществляется данное макросостояние, тем меньше энтропия системы.

Рост энтропии в изолированной системе, где происходят необратимые процессы, означает движение системы в направлении наиболее вероятного состояния, которым является состояние равновесия. Можно сказать, что энтропия является мерой беспорядка системы; чем больше беспорядка в ней, тем выше энтропия. В этом заключается физический смысл энтропии.

В состоянии термодинамического равновесия молекулы распределены равномерно по объёмам, при этом все направления в пространстве равноправны. В системе наблюдается максимальный беспорядок. Термодинамическая вероятность, а, следовательно, энтропия равновесного состояния системы максимальна.

Неравновесная термодинамическая система после прекращения действия источника, поддерживающего её в неравновесном состоянии, с течением времени переходит в наиболее вероятное равновесное состояние. Такой переход сопровождается ростом энтропии. Следовательно, по изменению энтропии можно судить о направлении протекания самопроизвольного процесса.

Второе начало термодинамики — один из основных законов термодинамики, устанавливающий необратимость макроскопических процессов, протекающих с конечной скоростью. Другими словами, это закон, устанавливающий направление протекания самопроизвольных процессов. Исторически второе начало термодинамики возникло из анализа работы тепловых машин [1-5,10]. Существует несколько формулировок второго начала термодинамики. Во-первых, второе начало термодинамики накладывает ограничения на возможности циклического получения механической работы за счёт полученной теплоты (формулировки Клаузиуса и Томсона (Кельвина)). Во-вторых, второе начало термодинамики с помощью понятия энтропии позволяет судить о направлении протекания процессов в системе (формулировка Больцмана).

Формулировка Клаузиуса.

Теплота не может самопроизвольно перейти от более холодного тела к более нагретому без каких-либо других изменений в системе.

Источник