- Вероятностный подход измерения информации

- Что означает вероятностный способ измерения информации

- Производные единицы измерения количества информации

- Методы измерения количества информации

- Алфавитный подход к измерению количества информации

- Вероятностный подход к измерению количества информации

- Задача 1.

- Задача 2.

- Задача 3.

- Задача 4.

- Задача 5.

- Задача 6.

- Задача 7.

- Задача 8.

Вероятностный подход измерения информации

Информация нуждается в измерении. На практике количество информации измеряется с точки зрения синтаксической адекватности. Исторически сложились два подхода к измерению информации: вероятностный и объемный. В 1940-х гг. К. Шеннон предложил вероятностный подход, а работы по созданию ЭВМ способствовали развитию объемного подхода.

Рассмотрим вероятностный подход к измерению количества информации.

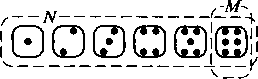

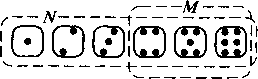

Пусть системаа может принимать одно из N состояний в каждый момент времени, причем каждое из состояний равновероятно. Например, в качестве системы могут выступать опыты с подбрасыванием монеты (N = 2) или бросанием игральной кости (N= 6).Количество информации системы а вычисляется по формуле, предложенной Р. Хартли:H = H(a) = log2N= lnN/ln2.При N =2 количество информации минимально и равно Н = 1. Поэтому в качестве единицы информации принимается количество информации, связанное с двумя равновероятными состояниями системы, например: «орел» — «решка», «ложь» — «истина». Такая единица количества информации называется бит.Введем понятие вероятности. Вероятность событияА — это отношение числа случаев М, благоприятствующих событию А, к общему количеству случаев N:

Пример 1.Найти вероятность выпадения числа 6 при бросании кости.Решение. Всего граней у кости N = 6. Число 6 присутствует только на одной грани.

|

Следовательно, вероятность выпадения числа 6 при бросании кости: Р=M/N/

Пример 2.Найти вероятность выпадения числа, большего 3, при бросании кости.

Решение. Всего граней у кости N = 6. Чисел, больших 3, на гранях кости М= 3.

|

Следовательно, вероятность выпадения числа, большего 3, при бросании кости: P=M/N=3/6=1/2. Если N состояний системы не равновероятны, т.е. система находится в i-м состоянии с вероятностью Pi и при этом все состояния системы образуют полную группу событий, т.е. сумма вероятностей равна:

Из приведенных выражений следует, что количество информации максимально, если состояния системы равновероятны.

Объемный подход

Объем данных V в сообщении измеряется количеством символов (разрядов) в этом сообщении. В информатике в основном используется двоичная система счисления, т.е. все числа представляются двумя цифрами: 0 и 1. Поэтому минимальной единицей измерения данных является бит. Таким образом, 1 бит — это либо 0, либо 1. Элемент, принимающий всего два значения, называется двухпозиционным и просто реализуется аппаратно: например, двумя состояниями «включено» —«выключено», «ток есть» —«ток отсутствует».

Более подробно о системах счисления будет рассказано позже.

Наряду с битом используется укрупненная единица измерения — байт, равная 8 бит.При кодировании информации по Y разрядам с помощью X символов количество возможных различных комбинаций N определяется по формуле N=X y (этосоотношение определяет число размещений с повторениями). При двоичном кодировании (Х=2) количество возможных различных комбинаций N определяется по формуле N=2 Y .

Напомним таблицы размерностей:

1 бит — самая маленькая единица информации — условно один «О» или одна «1».

1 байт = 8 бит (8 = 2 3 ); в международной системе кодов ASCII (AmtricanStandardCodeforInformationInterchange, Американский стандартный код обмена информацией) каждый символ кодировался одним байтом, чтопозволяло закодировать

1 Кбайт (килобайт) = 1024 байт (2 10 байт). По этому поводу есть анекдот, что физик думает, что в одном килобайте 1000 байт, а программист — что в одном килограмме 1024 грамма.

1 Мбайт (мегабайт) = 1024 Кбайта (2 10 Кбайт или 2 20 байт).

1 Гбайт (гигабайт)=1024 Мбайта (2 10 Мбайт или 2 30 байт).

1 Тбайт (терабайт)=1024 Гбайта (2 10 Гбайт или 2 40 байт).

В недалеком будущем нас ожидают:

1 Пбайт (петабайт) =1024 Тбайта (2 10 Тбайт или 2 50 байт).

1 Эбайт (экзабайт) =1024 Пбайта (2 10 Пбайт или 2 60 байт).

1 Збайт (зеттабайт) =1024 Эбайта (2 10 Эбайт или 2 70 байт).

1 Йбайт (йоттабайт) =1024 Збайта (2 10 Збайт или 2 80 байт)

Пример 2.8.Сообщение в двоичной системе счисления 10010010 имеет объем данных V = 8 бит. Этот объем данных представляется 1 байтом.

Для удобства использования введены и более крупные единицы объема данных:

1 024 байт = 1 килобайт (Кбайт);

1 024 Кбайт = 1 мегабайт (Мбайт) = 1 024 2 байт = 1048 576 байт;

1 024 Мбайт = 1 гигабайт (Гбайт) = 1 024 3 байт;

1 024 Гбайт = 1 терабайт (Тбайт) = 1 024 4 байт;

1 024 Тбайт = 1 пентабайт (Пбайт) = 1 024 5 байт.

Общий объем информации в книгах, цифровых и аналоговых носителях за всю историю человечества составляет по оценкам 10 18 байт. Зато следующие 10 18 байт будут созданы в течение пяти —семи лет.

Отличие объема данных от количества информации заключается в следующем: объем данных выражается только целыми значениями, а количество информации — вещественными.

Формулу Хартли можно использовать для определения объема данных. При этом результат округляется в большую сторону, так как минимальной ячейкой памяти в ЭВМ является байт. Поэтому, заняв только часть байта (его несколько бит), оставшаяся часть байта не используется.

Пример 2.9.В сообщениях используются только первые шесть букв латинского алфавита: А, В,С, D, Е, F.Сколько байт необходимо для хранения сообщения «AABBCCD»?

Решение. Определим, сколько бит необходимо для хранения одной буквы по формуле Хартли:

Результат округлим в большую сторону, следовательно:

Тремя битами можно представить 8 комбинаций: ООО, 001, 010, 011, 100, 101, 110, 111. Для кодирования шести букв используются первые шесть комбинаций, а две последние комбинации не используются.

Для сообщения, состоящего из М = 7 букв, необходимо

Vc = М*Vb = 7 • 3 = 21 бит = 2,625 байт.

Результат вновь округлим в большую сторону:

Информатика и ее структура

Информатика — это наука и вид практической деятельности, связанные с процессами обработки информации с помощью вычислительной техники.

Термин «информатика» произошел от слияния двух французских слов information (информация) и automatique (автоматика) и дословно определял новую науку об «автоматической обработке информации». В англоязычных странах информатика называется computerscience (наука о компьютерной технике).

Информатика представляет собой единство разнообразных отраслей науки, техники и производства, связанных с переработкой информации с помощью вычислительной техники и телекоммуникационных средств связи в различных сферах человеческой деятельности.

Основная задача информатики заключается в определении общих закономерностей процессов обработки информации: создания, передачи, хранения и использования в различных сферах человеческой деятельности. Прикладные задачи связаны с разработкой методов, необходимых для реализации информационных процессов с использованием технических средств.

Информатика включает в себя следующие разделы.

I. Теоретическая информатика.Это часть информатики, включающая в себя ряд подразделов, тесно связанных с другой наукой — математикой. В теории информации и кодирования изучается информация как таковая, ее свойства, способы измерения количества информации. Областью исследования теории алгоритмов и автоматов являются методы переработки информации с помощью вычислительных систем. Теория формальных языков и грамматик рассматривает правила построения простейших языков с небольшим числом синтаксических конструкций, называемых языками программирования. Теория принятия решений и исследования операций связана с использованием информации для принятия решений и оценки их оптимальности. Теоретическая информатика использует математические методы для общего изучения процессов обработки информации.

II. Вычислительная техника.Это раздел, включающий в себя общие принципы построения вычислительных систем. Примером вычислительной системы является персональный компьютер, или ЭВМ. Этот раздел не связан с вопросами физической разработки, реализации и производства элементов вычислительных систем. Здесь рассматривается архитектура вычислительных систем— соглашение о составе, назначении, функциональных возможностях и принципах взаимодействия элементов внутри вычислительных систем и вычислительной системы с другими устройствами. Примерами принципиальных, ставших классическими решений в этой области являются архитектура фон Неймана компьютеров первых поколений, шинная архитектура ЭВМ, архитектура параллельной или многопроцессорной обработки информации.

III. Программирование.Это деятельность, направленная на разработку программного обеспечения вычислительной техники. Программирование делится на разделы, связанные с разработкой соответствующих типов программного обеспечения. Программное обеспечение, непосредственно управляющее составными частями вычислительной техники, называется системным. Системный уровень программного обеспечения составляют операционные системы. Служебное программное обеспечение— это архиваторы, антивирусы, программы управления файлами и папками. Служебное программное обеспечение предназначено для выполнения некоторых вспомогательных функций. Прикладное программное обеспечение— это программы для решения большинства задач пользователя. Прикладное программное обеспечение включает в себя офисные, графические, справочные программы, среды разработки программ и др.

IV. Информационные системы.Это раздел информатики, связанный с решением проблем анализа потоков информации в различных сложных системах, их оптимизации, структурировании, принципах хранения и поиска информации по запросу пользователя. Примерами информационных систем являются информационносправочные, информационно-поисковые, глобальные системы или сети хранения и поиска информации.

V. Искусственный интеллект.Это область информатики, в которой решаются сложнейшие проблемы, находящиеся на пересечении с психологией, физиологией, языкознанием и другими науками. Исторически сложились три основных направления развития систем искусственного интеллекта. Целью работ первого направления является создание алгоритмического и программного обеспечения вычислительных машин, позволяющего решать интеллектуальные задачи не хуже человека. В рамках второго подхода объектом исследований являются структура и механизмы работы мозга человека, а конечная цель заключается в моделировании функционирования.

Источник

Что означает вероятностный способ измерения информации

Для информации существуют свои единицы измерения информации. Если рассматривать сообщения информации как последовательность знаков, то их можно представлять битами, а измерять в байтах, килобайтах, мегабайтах, гигабайтах, терабайтах и петабайтах.

Давайте разберемся с этим, ведь нам придется измерять объем памяти и быстродействие компьютера.

Единицей измерения количества информации является бит – это наименьшая (элементарная) единица.

Байт – основная единица измерения количества информации.

Байт – довольно мелкая единица измерения информации. Например, 1 символ – это 1 байт.

Производные единицы измерения количества информации

1 килобайт (Кб)=1024 байта =2 10 байтов

1 мегабайт (Мб)=1024 килобайта =2 10 килобайтов=2 20 байтов

1 гигабайт (Гб)=1024 мегабайта =2 10 мегабайтов=2 30 байтов

1 терабайт (Гб)=1024 гигабайта =2 10 гигабайтов=2 40 байтов

Запомните, приставка КИЛО в информатике – это не 1000, а 1024, то есть 2 10 .

Методы измерения количества информации

Итак, количество информации в 1 бит вдвое уменьшает неопределенность знаний. Связь же между количеством возможных событий N и количеством информации I определяется формулой Хартли:

Алфавитный подход к измерению количества информации

При этом подходе отвлекаются от содержания (смысла) информации и рассматривают ее как последовательность знаков определенной знаковой системы. Набор символов языка, т.е. его алфавит можно рассматривать как различные возможные события. Тогда, если считать, что появление символов в сообщении равновероятно, по формуле Хартли можно рассчитать, какое количество информации несет в себе каждый символ:

Вероятностный подход к измерению количества информации

Этот подход применяют, когда возможные события имеют различные вероятности реализации. В этом случае количество информации определяют по формуле Шеннона:

I – количество информации,

N – количество возможных событий,

Pi – вероятность i-го события.

Задача 1.

Шар находится в одной из четырех коробок. Сколько бит информации несет сообщение о том, в какой именно коробке находится шар.

Имеется 4 равновероятных события (N=4).

По формуле Хартли имеем: 4=2 i . Так как 2 2 =2 i , то i=2. Значит, это сообщение содержит 2 бита информации.

Задача 2.

Чему равен информационный объем одного символа русского языка?

В русском языке 32 буквы (буква ё обычно не используется), то есть количество событий будет равно 32. Найдем информационный объем одного символа. I=log2 N=log2 32=5 битов (2 5 =32).

Примечание. Если невозможно найти целую степень числа, то округление производится в большую сторону.

Задача 3.

Чему равен информационный объем одного символа английского языка?

Задача 4.

Световое табло состоит из лампочек, каждая из которых может находиться в одном из двух состояний (“включено” или “выключено”). Какое наименьшее количество лампочек должно находиться на табло, чтобы с его помощью можно было передать 50 различных сигналов?

С помощью N лампочек, каждая из которых может находиться в одном из двух состояний, можно закодировать 2 N сигналов.

2 5 6 , поэтому пяти лампочек недостаточно, а шести хватит. Значит, нужно 6 лампочек.

Задача 5.

Метеостанция ведет наблюдения за влажностью воздуха. Результатом одного измерения является целое число от 0 до 100, которое записывается при помощи минимально возможного количества битов. Станция сделала 80 измерений. Определите информационный объем результатов наблюдений.

В данном случае алфавитом является множество чисел от 0 до 100, всего 101 значение. Поэтому информационный объем результатов одного измерения I=log2101. Но это значение не будет целочисленным, поэтому заменим число 101 ближайшей к нему степенью двойки, большей, чем 101. это число 128=2 7 . Принимаем для одного измерения I=log2128=7 битов. Для 80 измерений общий информационный объем равен 80*7 = 560 битов = 70 байтов.

Задача 6.

Определите количество информации, которое будет получено после подбрасывания несимметричной 4-гранной пирамидки, если делают один бросок.

Пусть при бросании 4-гранной несимметричной пирамидки вероятности отдельных событий будут равны: p1=1/2, p2=1/4, p3=1/8, p4=1/8.

Тогда количество информации, которое будет получено после реализации одного из них, можно вычислить по формуле Шеннона:

I = -[1/2 * log2(1/2) + 1/4 * log2(1/4) + 1/8 * log(1/8) + 1/8 * log(1/8)] = 14/8 битов = 1,75 бита.

Задача 7.

В книге 100 страниц; на каждой странице — 20 строк, в каждой строке — 50 символов. Определите объем информации, содержащийся в книге.

Задача 8.

Оцените информационный объем следующего предложения:

Тяжело в ученье – легко в бою!

Так как каждый символ кодируется одним байтом, нам только нужно подсчитать количество символов, но при этом не забываем считать знаки препинания и пробелы. Всего получаем 30 символов. А это означает, что информационный объем данного сообщения составляет 30 байтов или 30 * 8 = 240 битов.

Источник